Künstliche Intelligenz in der Hochschullandschaft: Balance zwischen Innovation und Selbstbestimmung

Künstliche Intelligenz in der Hochschullandschaft: Balance zwischen Innovation und Selbstbestimmung

27.08.25

In diesem Blogbeitrag berichtet Malte Dreyer, Direktor des Computer- und Medienservice der Humboldt-Universität zu Berlin, über den aktuellen Stand der Anwendung von KI-Programmen an Hochschulen und Universitäten und die Punkte, an denen es scheitert. Dabei geht er besonders auf die Herausforderungen ein, die sich stellen, wenn große Organisationen wie Universitäten eine lokale KI-Infrastruktur bereitstellen möchten. Außerdem erklärt er, warum KI-Literacy eine institutionelle Aufgabe ist und welche Rolle digitale Souveränität dabei spielt.

Die rasante Entwicklung künstlicher Intelligenz (KI) konfrontiert Hochschulen mit zahlreichen grundlegenden Fragen in den Bereichen Forschung, Lehre und Verwaltung. Von besonderer Bedeutung ist dabei die Frage, welche Fähigkeiten Hochschulen selbst entwickeln, in Hochschulverbünden gemeinsam erarbeiten, von externen Anbietern einkaufen und inwieweit sie sich dabei einen selbstbestimmten Etateinsatz erhalten. Als Bildungs- und Forschungseinrichtungen sowie als bedeutende Arbeitgeber müssen Hochschulen eine Balance zwischen innovativer Nutzung und selbstgestalteter strategischer Steuerbarkeit finden.

KI-Adoption an Hochschulen

Auch an Hochschulen nutzen insbesondere KI-affine Akteure LLMs (Large Language Models) intensiv und erweitern in der Interaktion mit generativer KI kontinuierlich ihre digitalen Kompetenzen. Diese Akteure integrieren KI umfassend in ihren beruflichen Alltag, verarbeiten Daten eigenständig, konzipieren Prototypen, automatisieren Arbeitsprozesse und erkunden systematisch neue Anwendungsmöglichkeiten.

Diese Akteure berichten von substanziellen Kompetenzgewinnen durch den Einsatz generativer KI-Systeme, darunter die Aneignung von Programmierfertigkeiten, die Fähigkeit zur Rezeption fremdsprachlicher Inhalte sowie die Beherrschung diverser Sprachregister und Kommunikationsstile. Für viele Hochschulangehörige stellt dies eine erhebliche Erweiterung ihrer professionellen Handlungsmöglichkeiten dar.

Aktuelle Forschungsbefunde deuten darauf hin, dass diese Form der „Self Collaboration“ zwischen Mensch und KI Leistungen ermöglicht, die jenen traditioneller Teamarbeit ohne KI-Unterstützung entsprechen können.

Gleichzeitig findet an Hochschulen eine systematische Diskussion der Technologie-Möglichkeiten und -Auswirkungen statt, um auch die längerfristigen Konsequenzen der institutionellen KI-Adoption besser abschätzen zu können. Der institutionelle Einsatz ist indessen häufig noch nicht systematisch integriert und stark von Experimenten und Pilotphasen geprägt.

ZKI Top-Trends-Umfrage 2025

In der ZKI Top-Trends-Umfrage 2025 wurde als ein Schwerpunktthema nach den Entwicklungen im Bereich KI gefragt. Hochschulen setzen demnach auf eine strategische Mischung verschiedener Lösungen. Neben etablierten kommerziellen Plattformen wie ChatGPT und Microsoft Copilot entwickeln Hochschulen zunehmend eigene Lösungen wie HAWKI und UniGPT. Parallel dazu gewinnen weitere Open-Source-Alternativen an Bedeutung. Hierbei zeigt sich eine große Bandbreite der eingesetzten Werkzeuge: von universellen Sprachmodellen über spezialisierte Übersetzungstools wie DeepL bis hin zu Entwicklungsumgebungen wie GitHub Copilot. Diese Vielfalt deutet darauf hin, dass Hochschulen KI nicht als die Etablierung einer monolithischen Lösung verstehen, sondern als ein Ökosystem verschiedener, komplementärer Technologien.

Hochschulen investieren dafür in den Ausbau der Rechenkapazitäten, wobei sowohl lokale HPC-Cluster, NHR-Ressourcen und überregionale GPU-Infrastrukturen als auch Cloud-basierte Lösungen zum Einsatz kommen. Im Bereich der Lehre entstehen spezifische Lehrveranstaltungen und Module, die sowohl technische Kompetenzen als auch kritisches Verständnis für KI-Technologien vermitteln. Die organisatorische Dimension zeigt, dass Hochschulen die KI-Integration als eine strategische Aufgabe verstehen, die systematische Governance erfordert. Lizenzmanagement und -beschaffung werden zu zentralen Funktionen für die Einführung von KI-Diensten. Wie bei allen Digitalisierungsvorhaben fällt auch bei diesem Thema Datenschutz und Informationssicherheit eine zentrale Rolle zu.

Perspektiven und Trends

Die Ergebnisse der Umfrage verdeutlichen, dass die Integration von KI alle Ebenen der Institution umfasst. Der Trend geht in Richtung einer hybriden Strategie, die kommerzielle, selbstentwickelte und Open-Source-Lösungen kombiniert. Hochschulen streben danach, ihre Autonomie und Gestaltungskraft zu bewahren, während sie gleichzeitig von den Innovationen des kommerziellen KI-Sektors profitieren möchten.

Die Umfrage erfragte auch, welche Dienste aktuell in Planung sind. Im Zentrum der Entwicklungen steht der Ausbau technologischer Grundlagen. Hochschulen investieren sowohl in Hardware-Infrastrukturen wie GPU-Cluster und HPC-Systeme als auch in softwareseitige Lösungen wie lokale Large Language Models. Der geplante Aufbau von RAG-Systemen (Retrieval-Augmented Generation) zeigt das Bestreben, eigene hochschulspezifische KI-Ökosysteme zu entwickeln, die Datensouveränität und optimale Performance gewährleisten. Chatbots und Dialogsysteme werden für Studienberatung, IT-Support und Verwaltung geplant. Auch Microsoft-Tools wie Copilot und Übersetzungsdienste wie DeepL werden genannt.

Die KI-Integration wird zudem als übergreifende Aufgabe gesehen, was sich in strategischen Kooperationsstrukturen wie Connect.NRW widerspiegelt. Der Aufbau von Qualifizierungsangeboten und Compliance-Lösungen im Umfeld des AI Acts adressiert die Bedeutung von KI im Bereich Personalentwicklung und rechtssicherer Implementierung.

Das Finanzierungsdilemma: Ökonomische Abhängigkeiten und Lock-In-Mechanismen

Ein zentrales Problem bei der KI-Nutzung stellen die derzeit noch steigenden Kosten kommerzieller Anbieter dar. Mit jährlich drei- bis vierstelligen Kosten pro Nutzer:in für die Pro-/Max-Accounts der großen KI-Anbieter, wie sie für eine intensive Nutzung erforderlich wären, ist eine Skalierung auf alle Angehörigen der Hochschulen finanziell herausfordernd. Experimentelle Projekte mit LLMs können ohne Weiteres mehrere zehn oder hundert Millionen Tokens verbrauchen, was bei den etablierten Anbietern dynamische Kosten im jeweils drei- oder vierstelligen Bereich verursachen kann – zusätzliche und kaum planbare Kosten, die in den meisten Hochschulbudgets nicht im Rahmen einer IT-Grundversorgung verfügbar sind.

Diese Kostenfragen können zu problematischen Lock-In-Effekten führen, wenn Hochschulen aufgrund der hohen Kosten auf Experimente und den Aufbau eigener Kompetenzen verzichten. Dies kann wiederum dazu führen, dass sie die notwendige Expertise nicht entwickeln, um alternative Lösungen zu evaluieren, und somit stärker von etablierten, aber teuren Anbietern abhängig bleiben.

Mehrstufige Kooperationsarchitektur: Strategische Optionen für unterschiedliche Hochschultypen

Offene Experimentierräume können nicht nur den Einsatz von KI an Hochschulen erhöhen und den Kompetenzaufbau fördern, sondern auch das Bewusstsein für Fragen zur Souveränität von Hochschulinfrastruktur bei den Nutzenden steigern. Große Universitäten mit umfangreichen Ressourcen haben in der Regel bessere Möglichkeiten, eigenständige KI-Infrastrukturen zu entwickeln und eine breitere Expertise innerhalb ihrer Community aufzubauen. Aus dieser Verantwortung heraus sollten die Errungenschaften auch mit anderen Hochschulen offen geteilt werden.

Mittlere und kleinere Hochschulen profitieren besonders von kooperativen Ansätzen. Regionale Experimentierverbünde ermöglichen niederschwellige Kooperationen für alle Hochschulangehörigen durch gemeinsam finanzierte experimentelle Umgebungen. Solche Konsortien könnten innovative Ansätze risikoarm erproben und es auch kleineren Institutionen ermöglichen, von lokalen KI-Infrastrukturen zu profitieren, ohne die vollen Kosten und Risiken allein tragen zu müssen.

Die deutschen KI-Zentren bieten eine zusätzliche strategische Option, indem sie standardisierte KI-Dienste bereitstellen, die von vielen Hochschulen genutzt werden können. Allerdings müssen Hochschulen die strukturellen Limitationen dieser Zentren berücksichtigen: Sie sind darauf ausgelegt, wenige Dienste mit großen GPU-Kapazitäten anzubieten, können aber nicht viele kleine, spezialisierte Anwendungen pflegen.

Fachspezifische Verbünde bilden eine zusätzliche wichtige Ebene, auf der disziplinäre oder thematische Kooperationen für spezialisierte KI-Anwendungen oder höhere Leistungsanforderungen entwickelt werden können. Schließlich ermöglichen nationale und europäische Spitzenforschungskooperationen Hochleistungsanwendungen für anspruchsvolle Forschungsprojekte mit internationaler Ausstrahlung.

Souveränitätsstrategien durch lokale Infrastrukturen

Spezialisierte Dienstleister können bereits heute bei der Auswahl und dem Betrieb von Large Language Models vor Ort unterstützen. Diese Services umfassen häufig nicht nur den reinen Betrieb der Hardware vor Ort an den Hochschulen, sondern auch Beratung bei der Hardware-Beschaffung sowie die Auswahl und Pflege von KI-Anwendungen. Sie ermöglichen es, auch bei begrenzten internen Kompetenzen und beschränkten Budgets professionelle KI-Systeme vor Ort zu betreiben. Bei sorgfältiger Gestaltung der Anbieterbeziehung können unlösbare Abhängigkeiten auf diese Weise vermieden werden. Gleichzeitig bleiben sensible Forschungsdaten und interne Prozesse im kontrollierten Umfeld der Hochschule.

Die Technik dahinter

Eine zentrale Frage bei der lokalen Bereitstellung von KI-Infrastruktur ist die Wahl der eingesetzten Modelle. In der Vergangenheit wurden häufig Llama-basierte Modelle des US-amerikanischen Anbieters Meta verwendet, deren Lizenzen open-source-ähnlich konzipiert waren. Aufgrund der Lizenzbeschränkungen, die die Nutzung dieser Modelle ab Version 3.2 in Europa ausschließen, ist diese Option nicht mehr verfügbar. Somit sind von US-amerikanischen Anbietern für Hochschulen hauptsächlich die Modelle von Google (zum Beispiel Gemma) und Microsoft (zum Beispiel Phi) verfügbar.

Spätestens seit Dezember 2024 stehen mit der Veröffentlichung des DeepSeek V3-Modells auch chinesische Modelle im Fokus der Aufmerksamkeit. Obwohl es bereits zuvor leistungsstarke LLMs aus China gab, markieren diese Veröffentlichungen einen Meilenstein bei den öffentlich zugänglichen LLMs. Zuvor gab es keine nicht-US-Modelle, die in Benchmarks Spitzenpositionen erreichten. Dabei werden die Gewichte der chinesischen Modelle – im Gegensatz zu den US-Modellen – häufig mit unveränderten Open-Source-Lizenzen (DeepSeek V3 z.B. unter MIT-Lizenz veröffentlicht. Seitdem sind chinesische Modelle in Benchmarks kontinuierlich auf den Top-Positionen zu finden. Mit den GLM-Modellen von Zhipu AI, einem Spin-off der Pekinger Tsinghua Universität, gibt es auch eine Reihe von frei verfügbaren Modellen aus dem universitären Umfeld, die regelmäßig durch ihre Leistungsfähigkeit und moderne Architektur auffallen.

Aus Europa stammen die Modelle von Mistral, die sehr leistungsfähig sind und ebenso unter freien Lizenzen verfügbar waren. Seit Herbst 2024 hat Mistral jedoch die Veröffentlichung freier Top-Modelle eingestellt und stellt nur noch kleinere Modelle zur freien Nutzung bereit. Die Top-Modelle Mistral Medium und Mistral Large sind nun ausschließlich über kommerzielle Lizenzen erhältlich, entweder für den Einsatz vor Ort oder als SaaS (Software as a Service). Für den Einsatz an Hochschulen bietet Mistral weitreichende Rabatte an. Der kanadische Anbieter Cohere stellt seine großen Modelle dagegen auch unter freien Lizenzen zur Verfügung. Das derzeitige Top-Modell von Cohere – Command-A – wird beispielsweise unter einer CC-Lizenz angeboten.

Für den Betrieb dieser Top-Modelle sind umfangreichere Ressourcen erforderlich als für die Einstiegsmodelle. So gibt es Modelle, die beispielsweise ab mindestens zwei H100-GPUs (je circa 30 T €) betrieben werden können, wie Command-A. Mistral Medium oder größere Qwen-Modelle des Anbieters Alibaba erfordern mindestens vier H100-Karten, und die großen Deepseek-Modelle sind nur mit mindestens acht oder sechzehn H100-Karten regulär betreibbar. Trotz der höheren Ressourcenanforderungen liegt der Vorteil darin, dass somit Open-Source-Modelle jeder Leistungskategorie verfügbar sind und man je nach Einsatzzweck und Budget prüfen kann, welches Modell verwendet werden soll. Insofern stellen die chinesischen Modelle eine echte Bereicherung für den Open-Source-Bereich dar und beleben den Wettbewerb unter den Anbietern. Wie sich dies für die Zukunft gestaltet, ist schwer abzuschätzen. Auch die chinesischen Modelle orientieren sich derzeit noch an den GPU-Karten von Nvidia. Für die Zukunft ist zu erwarten, dass hier eine stärkere Ausrichtung hin zu chinesischer Hardware, zum Beispiel von Huawei, stattfinden wird – derzeit noch eher als alternative Option anstelle von Nvidia-Karten. Hier könnte eine stärkere Marktabgrenzung den Einsatz von chinesischen Open-Source-Modellen mit weiteren Restriktionen in der Zukunft verändern.

Die Firma Mistral erarbeitet derzeit spezielle Angebote für Hochschulen, bei denen nicht nur einzelne Modelle an Hochschulen lizenziert werden, sondern die gesamte KI-Infrastruktur, inklusive Chats, RAG, Agenten und weiteren Mehrwertdiensten – sowohl zur Installation vor Ort als auch als SaaS.

Hinzugefügt werden muss, dass im Zusammenhang mit Modellen für vollständige KI-Infrastrukturen nicht nur LLMs erforderlich sind, sondern auch die Bereitstellung von performanten Embedding- und Reranking-Modellen für RAG, von Speech-To-Text-Modellen sowie Text-To-Speech-Modellen für die Interaktion mittels Sprache und von Visionsmodellen zur Verarbeitung von grafischen Elementen oder zur Bilderzeugung. Die Beleuchtung der Open-Source-Aspekte in diesem Umfeld wäre ein gesonderter Artikel.

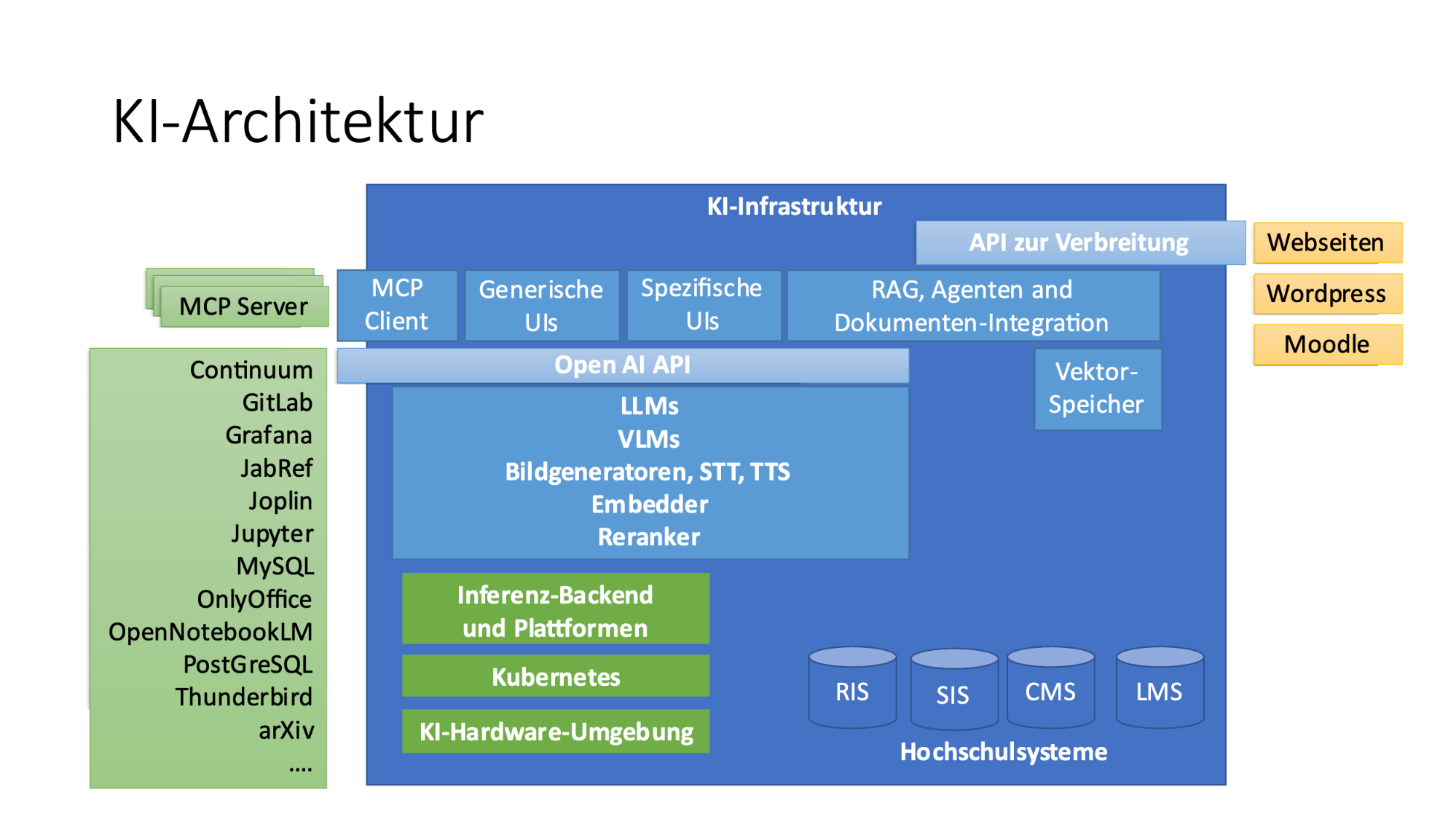

Eine mögliche Architektur für den Einsatz von KI an Hochschulen ist unter der folgenden Abbildung dargestellt:

Dreistufiges Infrastruktur-Modell nach HPC-Vorbild

Analog zum bewährten Tier-System im Nationalen Hochleistungsrechnen (NHR) im Bereich High Performance Computing lässt sich für Hochschulen ein gestuftes KI-Infrastruktur-Modell skizzieren:

Tier 3 – Experimentierraum: Diese Ebene bietet niederschwellige Zugänge für alle Hochschulangehörigen, vielfältige Lösungsoptionen und intensive Beratung. Hier können ohne Bedenken Erfahrungen gesammelt und Projekte realisiert werden. Diese Ebene sollte primär durch lokale oder kooperative Infrastrukturen abgedeckt werden.

Tier 2 – Spezialisierte Anwendungen: Diese Ebene umfasst strukturierte Dienstangebote für größere Projekte mit höherer Leistung, aber definierten Zugangskriterien. Hier können sowohl lokale Lösungen als auch Dienste der KI-Zentren zum Einsatz kommen.

Tier 1 – Hochleistungsbereich: Diese Ebene stellt zentrale Ressourcen für anspruchsvolle Forschungsprojekte mit maximaler Leistung und strengen Qualitätsvorgaben bereit. Diese Ebene wird primär durch nationale KI-Zentren und NHR-Infrastruktur abgedeckt.

AI-Literacy als institutionelle Aufgabe

Die erfolgreiche Integration von KI in Hochschulen erfordert eine umfassende Kompetenzentwicklung, die alle Hochschulgruppen einschließt. KI-Technologien betreffen nicht nur Forschung und Lehre, sondern auch Bereiche wie Verwaltung, Bibliothekswesen, IT-Services und Gebäudemanagement. Daher müssen Schulungsmaßnahmen alle Angehörigen der Hochschule erreichen. Erfahrungen zeigen, dass die Herausforderungen bei der Annäherung an das KI-Thema zwischen den verschiedenen Statusgruppen der Hochschule nur geringfügig variieren und die spezifischen Hintergründe in Diskussionen oft schnell in den Hintergrund treten.

Diese Schulungen sollten über die Vermittlung von Prompting-Techniken hinausgehen, wie sie in den vergangenen Jahren häufig angeboten wurden, und ein grundlegendes Verständnis für die Funktionsweise, Möglichkeiten und Grenzen aktueller KI-Technologien vermitteln. Nur so können Hochschulangehörige informierte Entscheidungen über KI-Einsatzmöglichkeiten treffen und Risiken angemessen bewerten.

Besonders wichtig ist die Entwicklung einer institutionellen AI-Literacy, die es ermöglicht, KI-Output kritisch zu validieren, ethische Implikationen zu erkennen und rechtliche Anforderungen zu berücksichtigen. Diese Meta-Kompetenz ist essenziell, um KI-Systeme in komplexen Hochschulkontexten verantwortungsvoll zu gestalten und zu nutzen.

Hochschulen können dabei ihre bestehenden Stärken in der überregionalen Kooperation nutzen: Schulungen zum AI Act müssen nicht an jeder Hochschule neu entwickelt werden, sondern können als gemeinsame Ressource im Sinne von Open Educational Resources (OER) bundesweit bereitgestellt werden. Erfahrungen zum erfolgreichen oder problematischen Einsatz von KI-Systemen sind von übergreifendem Nutzen und können allen Einrichtungen beim eigenen Einsatz helfen.

Integration in bestehende Hochschulsysteme: RAG und darüber hinaus

Ein weiterer Vorteil lokaler KI-Infrastrukturen besteht in der Möglichkeit, KI-Systeme direkt mit bestehenden Hochschulsystemen zu verknüpfen. Bereits heute ergeben sich Vorteile durch die direkte Anbindung von bestehenden Systemen an Large Language Models (LLMs) über Schnittstellen wie die OpenAI API. Dies ermöglicht die Verbindung lokaler Infrastrukturen mit Mailprogrammen wie Thunderbird, der Literaturverwaltungssoftware JabRef, GitLab oder freien Office-Paketen. Retrieval-Augmented Generation (RAG)-Technologien und agentische Ansätze erweitern Large Language Models um spezifische Dokumentensammlungen und weitere Quellen und Systeme, sodass diese gezielt institutionelle Daten verarbeiten können.

Erfolgreiche RAG-Anwendungen in Hochschulen umfassen beispielsweise die unterstützte Erstellung von Stellenausschreibungen gemäß Corporate Identity-Vorgaben, die Abfrage intelligenter Handlungsleitfäden für komplexe Verwaltungsprozesse, die Automatisierung von Prozessdokumentationen und die Generierung standardisierter Dokumente. RAG-Systeme sind jedoch weniger geeignet bei unklaren oder widersprüchlichen Datengrundlagen, da sie in solchen Fällen unvorhersehbare Ergebnisse produzieren können. Der Einsatz von RAG-Technologien erfordert daher eine systematische Bewertung der Datenqualität und -konsistenz sowie Erfahrung mit unterschiedlichen Einsatzzwecken. Diese Kompetenz müssen Hochschulen selbst aufbauen, wenn sie diese Entwicklungsperspektiven eigenständig steuern möchten.

Neben RAG-Technologien werden zunehmend weitere Protokolle wie das Model Context Protocol (MCP) oder das Agent-User Interaction Protocol (AG-UI) eingesetzt, um KI-Systeme systematisch mit weiteren Anwendungen zu verbinden und zu integrieren. Auch hier ist die Systemintegration ein zentrales Argument für lokale KI-Kapazitäten: Die Anbindung an lokale KI-Umgebungen geht nicht automatisch mit der Übertragung an nicht-europäische Anbieter einher und ermöglicht somit weitreichendere Möglichkeiten der KI-Integration.

Neben diesen Beispielen sind weitere innovative Austauschformate zu den folgenden Themen vorstellbar:

- KI-Zwillinge für die Lehre: Hochschulübergreifende Entwicklung von KI-Systemen, die Vorlesungsinhalte, Skripte und Mitschnitte intelligent verknüpfen. Diese Ansätze bieten nicht nur pädagogische Innovationen, verbesserte Inklusion und neue Zugangswege, sondern auch Möglichkeiten für internationale Kooperationen durch die multilinguale Natur moderner LLMs.

- Geteilte Experimentierräume: Virtuelle Kooperationsplattformen, in denen Hochschulangehörige verschiedener Institutionen gemeinsam KI-Experimente durchführen können, ohne institutionelle Grenzen zu überschreiten.

- Koordinierte Kompetenzentwicklung: Arbeitsteilige Spezialisierung in verschiedenen KI-Bereichen mit systematischem Erfahrungsaustausch zwischen den Partnerhochschulen.

Ausblick: Souveränität als Innovationsfaktor

Digitale Souveränität beim Einsatz von KI stellt für Hochschulen eine vielschichtige Herausforderung dar, die technische, finanzielle und strategische Aspekte umfasst. Durch differenzierte Ansätze – von lokalen Infrastrukturen über kooperative Modelle bis hin zur selektiven Nutzung zentraler Dienste – können Hochschulen ihre Unabhängigkeit bewahren oder stärken und gleichzeitig innovative KI-Anwendungen vorantreiben. Der Schlüssel liegt dabei in der Kombination technologischer Souveränität mit umfassender Kompetenzentwicklung und strategischer Systemintegration. Nur durch die Balance zwischen technologischer Unabhängigkeit und strategischer Kooperation können Hochschulen ihre Rolle als Innovationstreiber in einer KI-geprägten Zukunft erfolgreich gestalten.

Themencheckliste zur eigenen KI-Strategie

- Größengerechte Infrastruktur-Strategie: Eigenständiger Aufbau bei großen Hochschulen, kooperative Konsortien bei mittleren und kleinen Institutionen.

- Hybride Systemarchitektur: Strategische Kombination lokaler Infrastrukturen mit abgestimmter Nutzung dezentraler Dienste.

- Umfassende AI-Literacy-Programme: Systematische Kompetenzentwicklung für alle Hochschulgruppen mit Fokus auf Anwendung, kritisches Technologieverständnis sowie Möglichkeiten und Grenzen der Anwendung von KI.

- Strategische Systemintegration: Langfristige Planung für die Anbindung von KI-Systemen an kritische Hochschulinfrastrukturen.

- Kooperationsarchitektur: Entwicklung mehrstufiger Partnerschaftsmodelle von regionalen Verbünden bis zu europäischen Konsortien.

- Budgetplanung: Realistische Kostenabschätzung und Finanzierungsmodelle für nachhaltige KI-Nutzung.

- Experimentierkultur: Schaffung risikofreier Räume für KI-Innovation.

- Europäische Integration: Strategische Verschränkung der KI-Aktivitäten mit europäischen KI-Initiativen.

- Risiko-Einschätzung: Kontinuierliche Bewertung technologischer und ökonomischer Abhängigkeitsrisiken.

- IT-Sicherheit und Datenschutz: Besondere Aufmerksamkeit auf neue Herausforderungen und Risiken, die durch die Einführung von KI entstehen, um sicherzustellen, dass Sicherheitsmaßnahmen und Datenschutzrichtlinien stets aktuell und wirksam sind.

Autor

Malte Dreyer ist Direktor des Computer- und Medienservice (CMS) an der Humboldt-Universität zu Berlin. Der CMS ist der zentrale IT- und Mediendienstleister der Universität und mit der Abteilung Digitale Medien auch für die digitale Lehr- und Lerninfrastruktur zuständig. Zuvor war er bei der Max-Planck-Gesellschaft im Bereich digitaler Forschungsinfrastrukturen tätig. Als wissenschaftlicher Mitarbeiter hat er in Lübeck die Online-Studiengänge und die digitale Infrastruktur, das Instructional Design sowie die digitale Medienproduktion für Oncampus, die Virtuelle Fachhochschule und den Baltic Sea Virtual Campus mitkonzipiert und entwickelt. Die Umfrage wurde in der Rolle des Sprechers des Arbeitskreises Strategie und Organisation der deutschsprachigen Hochschulen im ZKI e.V. durchgeführt.

Mauritz Danielsson

Mauritz Danielsson

Peter van der Hijden

Peter van der Hijden

Annalisa Biehl

Annalisa Biehl