Chroniken und Chatbots: Ein Praxisbericht zu KI-gestütztem Lernen und Lehren im Fach Geschichte

Chroniken und Chatbots: Ein Praxisbericht zu KI-gestütztem Lernen und Lehren im Fach Geschichte

24.09.24

Im Sommersemester 2024 haben Katharina Eisenbarth und Alexa von Winning mit Studierenden des Faches Geschichte an der Universität Tübingen ein KI-Mentorat entwickelt. Von der Literaturrecherche bis zur Textgenerierung haben Studierende KI-Tools in verschiedenen Arbeitsbereichen ihres Studiums angewandt. Wenn die Nutzung der KI-Tools kritisch und fachlich fundiert geschieht, gehen Chroniken und Chatbots im Studium gut zusammen.

Einleitung

Am Fachbereich Geschichtswissenschaft der Universität Tübingen gibt es seit einigen Semestern eine Lehrveranstaltung, die Studierende in ihrem ersten oder zweiten Semester belegen: sogenannte „Übungen zum wissenschaftlichen Lesen und Schreiben“. Jede dieser Übungen hat ein fachwissenschaftliches Thema, aber im Vordergrund stehen die Praktiken des wissenschaftlichen Arbeitens. Es geht um Lesetechniken, Fragen des Exzerpierens, die Struktur wissenschaftlicher Texte und um das eigene Schreiben. Im Semesterverlauf schreiben die Studierenden drei Essays. Die Rückmeldungen der Lehrenden zu diesen Texten und studentisches „Peer Feedback“ nehmen großen Raum in den wöchentlichen Sitzungen ein.

Als sich diese Übungen im Fachbereich Geschichtswissenschaft gerade als Erfolgsmodell etabliert hatten, zog die KI in die deutschen Universitäten ein und stellte die Praktiken des wissenschaftlichen Arbeitens auf den Kopf. Lehrveranstaltungen mit rein schriftlichen Prüfungsleistungen wie Essays oder Hausarbeiten schienen besonders bedroht – und sind im Fach Geschichte doch unverzichtbar.

Mit Unterstützung der Fachschaft Geschichte haben wir diese Herausforderung im Sommersemester 2024 in Angriff genommen und eine Übung durch ein KI-Mentorat ergänzt. Es war ein Experiment mit offenem Ausgang: Was bleibt vom Studium übrig, wenn Chatbots und Chroniken aufeinandertreffen? Woche für Woche haben wir, eine Dozentin der osteuropäischen Geschichte und eine studentische Mitarbeiterin, gemeinsam mit den Studierenden KI-Tools getestet. Wir haben nach Wegen gesucht, wie wir die Tools produktiv in die Prozesse des wissenschaftlichen Lesens und Schreibens integrieren könnten. Der Beitrag berichtet von unseren Erfahrungen, wie KI-gestütztes Lernen und Unterrichten im Fach Geschichte funktionieren können.

Das KI-Mentorat: Informieren und Ausprobieren

Das Thema der Übung war die belarusische Geschichte im zwanzigsten Jahrhundert. Insbesondere haben wir uns mit den Erfahrungen der Zivilbevölkerung zwischen Weltkriegen, Umstürzen und Ideologien beschäftigt. Den Rhythmus der wöchentlichen Sitzungen haben wir auch für das KI-Mentorat übernommen. Das regelmäßige Arbeiten war gut, weil die Studierenden ihre inhaltlichen Kenntnisse parallel zu den KI-Fertigkeiten entwickeln konnten. Dies sorgte für wichtige Synergien. Denn KI lässt sich im Studium nach unserer Erfahrung nur in Bezug auf ein konkretes Thema, zu dem Expertise aufgebaut wird, produktiv nutzen.

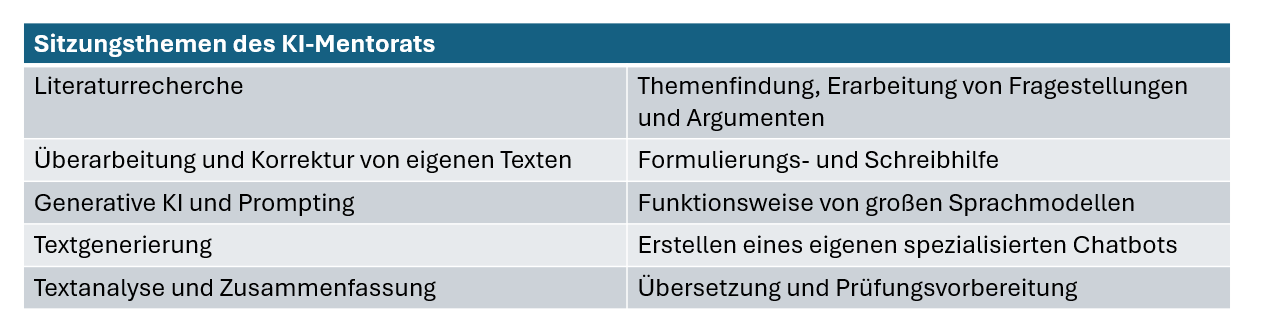

In jeder Sitzung beschäftigten wir uns mit einem KI-Anwendungsbereich, der im Geschichtsstudium relevant ist. Um Vergleiche zu ermöglichen und die ungeheure Vielfalt der Angebote zu erschließen, standen für jeden Anwendungsbereich mehrere Tools zur Auswahl. Neben KI-Tools, die für eine bestimmte Anwendung wie die Literaturrecherche entwickelt wurden, kamen in vielen Sitzungen Chatbots zum Einsatz. Sie lassen sich mit etwas Übung für sämtliche Anwendungsbereiche nutzen. Um den Studierenden eine Grundlage für den Umgang mit Chatbots zu liefern, haben wir in einer theorielastigeren Sitzung grob die Funktionsweise von großen Sprachmodellen erklärt.

Im Mentorat stand das Ausprobieren über dem Informieren. Nach einer kurzen Einführung zu den jeweiligen KI-Tools mit ein paar Tipps zur Anwendung konnten die Studierenden die KI-Tools in Einzel- oder Gruppenarbeit auf ihren eigenen Endgeräten testen. Dafür bearbeiteten sie Aufgabenstellungen zu den Inhalten der Übung, etwa zur belarusischen Erinnerung an den Zweiten Weltkrieg. In der Regel sollten die Studierenden entweder verschiedene Tools vergleichen oder aber KI-Tools herkömmlichen Methoden gegenüberstellen. Indem die Studierenden ihre Laptops an den Beamer anschlossen oder Chatverläufe in Google Docs kopierten, konnten wir die Ergebnisse direkt miteinander vergleichen und bewerten. Wir haben ausschließlich mit kostenlosen Nutzeraccounts gearbeitet.

Tools zur Literaturrecherche

Am Beginn jeder Hausarbeit stehen die Literatur- und Quellenrecherche. Die KI-Landschaft bietet für diese Aufgabe aktuell vor allem drei Tools: ScienceOS, Elicit und Research Rabbit. Die Studierenden sollten nach wissenschaftlicher Literatur zu Belarus im Zweiten Weltkrieg suchen und die Ergebnisse mit herkömmlichen Recherchemethoden (Datenbanken, Katalogen, Schneeballsystem) vergleichen. Das einhellige Fazit war, dass KI-Tools eine leistungsfähige Ergänzung zu den etablierten Methoden der Literaturrecherche sind. Aber sie bleiben eine Ergänzung und machen Datenbanken wie die Historical Abstracts nicht obsolet.

Auf den ersten Blick sahen die Ergebnisse der Literatursuchen vielversprechend aus: Die Tools liefern viel umfassendere Informationen als jede Datenbank. Neben den üblichen bibliografischen Angaben bieten sie zum Beispiel die Möglichkeit, Fragen zur Literatur zu stellen. So kann man die Tools auffordern, zwei Paper zu vergleichen oder die argumentative Stringenz eines Artikels zu bewerten. Die Ergebnisse sind oft erstaunlich gut. ScienceOS bietet den Nutzer:innen sogar verwandte Fragen zum Thema an, um die Recherche zu verfeinern. Wenn es um die gesellschaftliche Erinnerung an den Zweiten Weltkrieg in Belarus geht, schlägt das Tool vor, dass man auch fragen könnte, welche Rolle Denkmale in der Erinnerung spielen oder wie die Geschichte in belarusischen Schulen unterrichtet wird. Zu allen Fragen wird Literatur gleich mit angegeben.

Bei genauerem Hinsehen werden allerdings Schwachstellen deutlich. Die Tools beziehen sich in ihren Antworten oft nur auf frei verfügbare Abstracts, weil sie auf lizenzierte Gesamttexte nicht zugreifen können. Trotzdem suggerieren die Tools, dass sie Fragen „zur Literatur“ beantworten – und nicht nur zu einem kleinen Teil davon. Die Struktur der Ergebnisse hat außerdem Schlagseiten. Monografien gehen unter, Artikel und Paper werden bevorzugt. Für die Geschichtswissenschaft ist das problematisch. Die Recherche funktioniert auf Englisch zudem deutlich besser als auf Deutsch. Fast alle Tools basieren auf der Datenbank des Tools Semantic Scholar. Publikationen, die dort nicht gelistet sind, fallen unter den Tisch.

Ein großer Pluspunkt bleibt: Die Tools bieten mit nur wenigen Klicks einen schnellen Überblick über Themen und Forschungslandschaften. Mit Research Rabbit konnten die Studierenden per Schneeballsystem nach Literatur suchen, ohne dass sie sich die einzelnen Publikationen vorher beschaffen mussten. Visuelle Darstellungen illustrieren, welche Publikationen aufeinander verweisen. Wer die eigene Zotero-Bibliothek mit dem Tool verknüpft, bekommt Vorschläge auf Basis der bereits gesammelten Literatur präsentiert. Aber auch hier gilt: Das Tool führt nur die Titel auf, auf die es zugreifen kann.

Vorsicht bei der Textverbesserung

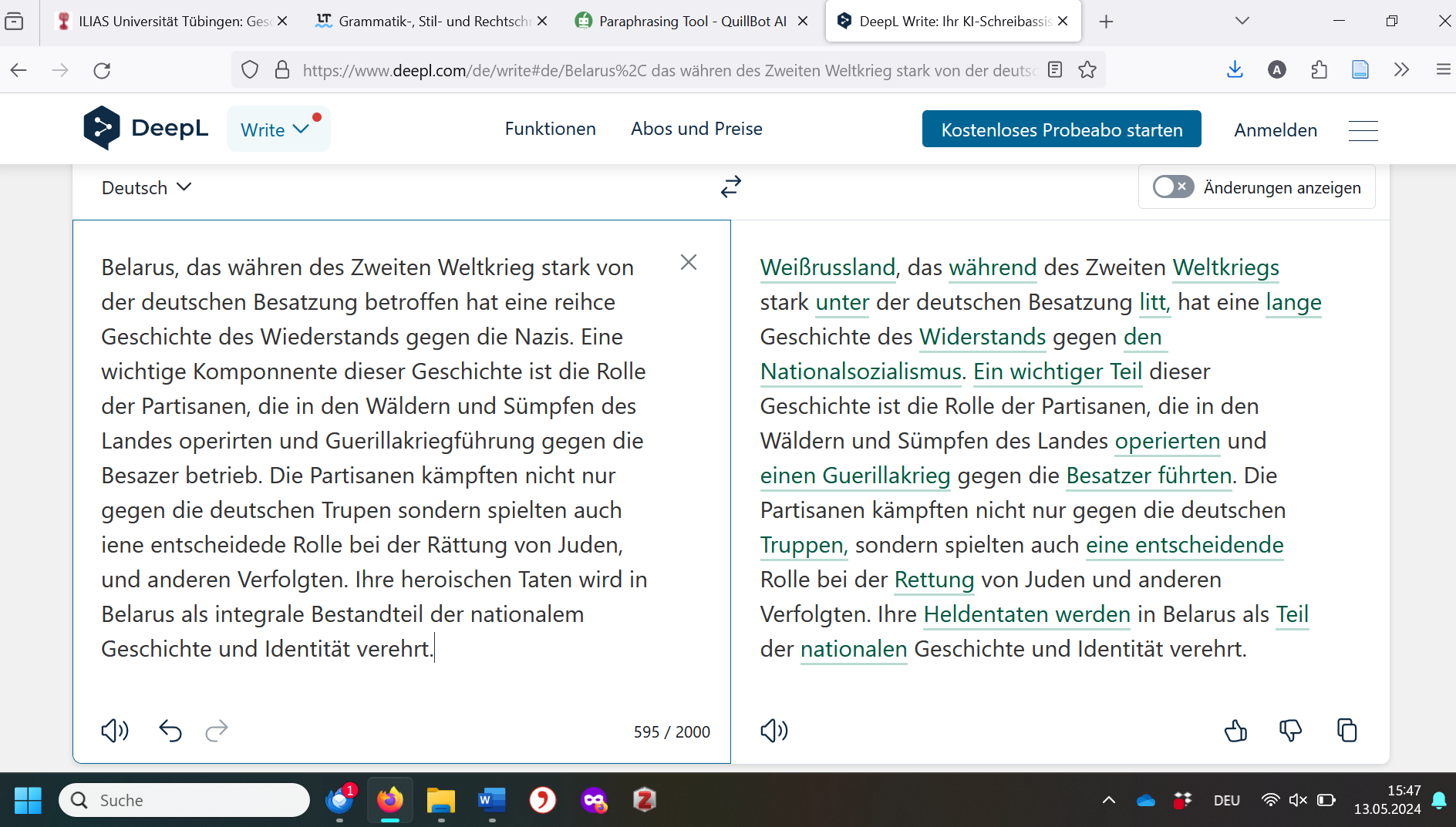

Weil das Schreiben für viele Studierende die größte Herausforderung ist, war das Interesse an Tools zu Überarbeitung und Verbesserung eigener Text groß. Auch hier gibt es ein reiches Angebot, darunter Language Tool, Quillbot, DeepL Write und Hemingway Editor. Einige dieser Tools können nicht nur sprachliche Fehler im Text erkennen, sondern auch Sätze umformulieren. Damit die Studierenden deren Leistungen bei Rechtschreibung, Grammatik und Stil ausprobieren konnten, haben wir einen Text mit zahlreichen Fehlern bereitgestellt (in der Illustration links). Im Verlauf der Sitzung fiel auf, dass manche Tools nicht alle Fehler im Text erkannt und markiert hatten. Außerdem zeigte sich, dass beim Paraphrasieren sowohl subtile Bedeutungsänderungen als auch inhaltliche Fehler eingeschleust wurden. DeepL Write änderte beispielsweise „Belarus“ ins anachronistische „Weißrussland“ und widersprach damit diametral den Seminardiskussionen.

Prompting mit Chatbots

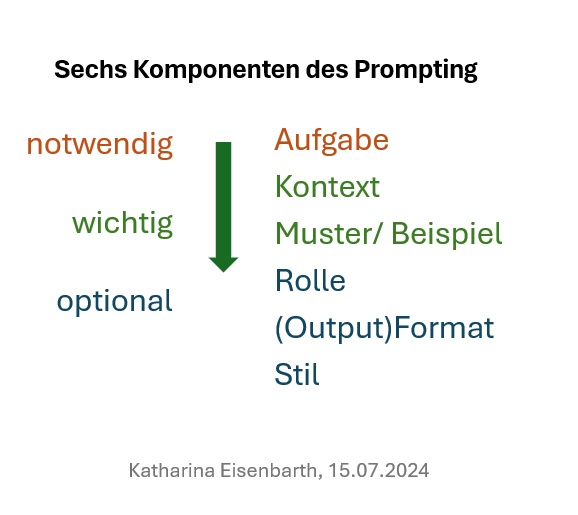

Erfolg bei der Arbeit mit Chatbots hängt von guten Prompts ab. Nachdem wir den Studierenden mit Beispielen erklärt hatten, aus welchen Komponenten ein guter Prompt besteht, haben sie selbst einen Prompt zur Textgenerierung entworfen. Das Ziel war, den Chatbot anzuweisen, einen Essay zu einer geschichtswissenschaftlichen Fragestellung zu generieren. In einer späteren Sitzung haben die Studierenden ihren Prompt getestet, indem sie die Fragestellung des ersten Essays einfügten und in einen Chatbot einspeisten. Zu diesem Zeitpunkt hatten die Studierenden den ersten Essay schon abgegeben und konnten die Ergebnisse der Chatbots mit ihren eigenen Texten vergleichen.

Die Essays der Chatbots waren beeindruckend. Mit nur einem Prompt lieferten die Chatbots einen Essay, der zumindest den formalen Kriterien entsprach. Einige Studierende erkannten in den Essays sogar ähnliche Argumente und Gedankengänge wie in ihren eigenen. Allerdings zeigte sich auch, dass die Chatbots immer einen standardisierten Aufbau verfolgten. Die Texte klangen generisch, mit auffälligen Floskeln und Phrasen. Wir hatten den Eindruck, dass die Chatbots nur der Form halber zwei Seiten gegenüberstellten und am Ende stets mit einem “einerseits…andererseits” schlossen.

Überraschend war außerdem, dass die Essays trotz expliziter Vorgabe im Prompt oft nicht den geforderten Textumfang erfüllten. Die Texte der Chatbots waren meist zu kurz. Mit ein paar Folgeanweisungen ließen sich die Essays aber erheblich verbessern. Bewährt hat sich auch die Strategie, dass sich die Chatbots selbst Feedback geben und dieses einarbeiten sollten.

Gute Essays: Ohne Seminarinhalte geht es nicht

Die wichtigste Erkenntnis auf allen Seiten – Dozentin, Mentorin und Studierende – nach 14 Wochen Mentorat war: Ohne inhaltliche Kenntnisse geht es auch mit der KI nicht. Wer das Seminarthema nicht kennt, kann keine guten Prompts schreiben und wird in der Folge nur schwache Ergebnisse bekommen: generische Texte, die Chronologien durcheinanderbringen und große Begriffe verwenden, ohne dass Zusammenhänge klar werden. Studierende, die die KI-Tools sinnvoll einsetzen und ihre Essays damit verbessern wollten, mussten die Grundzüge der belarusischen Geschichte ebenso im Kopf haben wie die im Seminar diskutierten historiografischen Narrative und Begriffe. Um zu guten Ergebnissen zu kommen, mussten sie den Output der KI deutlich modifizieren – zusammen mit den Tools oder manuell.

Die Seminarinhalte verloren mit dem Einzug der Chatbots nicht an Bedeutung, wie pessimistische Annahmen zur KI in geisteswissenschaftlichen Fächern es nahelegen könnten. Im Gegenteil: Als entscheidender Maßstab, um die Ergebnisse der verschiedenen Tools kritisch zu bewerten, erhielten sie in den Augen der Studierenden eine neue, markante Rolle. Die Vergleiche der Tools in den Praxisphasen des Mentorats zeigten den Studierenden eindrucksvoll, dass Vorsicht im Umgang mit der KI geboten ist. Während die Studierenden dank des KI-Mentorats wenig Zeit für die Literaturrecherche und -beschaffung benötigten, war ihre Fähigkeit, Texte und Argumente kritisch zu bewerten, sehr gefragt – und das auf einem anspruchsvollen Niveau. Das ist im Fach Geschichte eine wünschenswerte Entwicklung.

Den hohen Kontrollbedarf haben wir an Beispielen aus den studentischen Essays immer wieder im Plenum diskutiert. Für die Studierenden (und auch für uns als Dozentinnen) war es erhellend und erschreckend zu sehen, welche stillen Fortschreibungen alter Denkgewohnheiten die KI-generierten Texte enthielten. Wo es um den Stalinismus und seine Auswirkungen auf Belarus ging, unterschied die KI oft nicht zwischen den 1930er Jahren und der Nachkriegszeit. Beide Perioden gehören zum Stalinismus und unterscheiden sich doch fundamental. In anderen Fällen wurden historische Entwicklungen des Moskauer Zentrums in KI-generierten Texten auf die Lage in Minsk übertragen. Die unreflektierte Gleichsetzung des sowjetischen Zentrums mit den Peripherien ist ein typischer Fallstrick der osteuropäischen Geschichte, den wir im Seminar ausführlich besprochen hatten.

Es hat sich bewährt, die Seminarinhalte stärker und expliziter in die Fragestellungen der Essays zu integrieren. Denn die KI kann zwar in Windeseile Texte lesen, zusammenfassen und bewerten. Aber sie ist im Seminarraum nicht dabei. Nach unseren Erfahrungen ist es eine Überlegung wert, ob der Bezug auf Seminarinhalte nicht zu einem inhaltlichen Kriterium bei der Bewertung von Hausarbeiten und Essays erhoben werden sollte. Dass das die Seminardiskussionen aufwertet, wäre ein schöner Nebeneffekt.

Eine KI-informierte Lehrpraxis ist wichtig, aber ohne Kontrolle geht es nicht. Wir haben gute Erfahrungen damit gemacht, bei den studentischen Essays direkt grobe Angaben zu den verwendeten Tools und den eingesetzten Prompts zu verlangen. Auf Nachfrage müssen die Studierenden die gesamten Chatverläufe bereitstellen, die üblicherweise ohnehin in den Tools gespeichert werden. Natürlich schließt das Betrug nicht aus, aber die Erstellung eines separaten Chatverlaufs, um den tatsächlichen Einsatz der KI zu verschleiern, scheint doch recht aufwendig. Beim Korrigieren bekommt man als Dozentin zudem einen recht guten Eindruck davon, ob der Essay und die angegebenen Prompts einigermaßen übereinstimmen.

Kenntnisse und Kritik für Chroniken und Chatbots

Zu Beginn des Semesters gaben die meisten unserer Studierenden an, dass sie zögerlich mit dem Gebrauch von KI-Tools im Studium seien. Einige verwiesen auf rechtliche Unsicherheiten und andere gaben an, zu wenig über die Handhabung der Tools zu wissen. An den rechtlichen Rahmenbedingungen konnten wir in unserer Übung wenig ändern. Aber im Bereich der Handhabung haben wir deutliche Fortschritte erreicht. Im Laufe des Semesters gewannen alle Studierenden an Sicherheit, Kreativität und Reflektionsfähigkeit im Umgang mit den verschiedenen Tools.

Wenn die Nutzung der KI-Tools kritisch und fachlich fundiert geschieht, gehen Chroniken und Chatbots im Studium gut zusammen. Diese Kritikfähigkeit zu trainieren, ist das wichtigste Ziel des KI-gestützten Unterrichtens. Schwer ist das nicht: Denn die KI-generierten Ergebnisse bieten bei aller beeindruckenden Leistungsfähigkeit doch genug Material, um Kritik zu üben.

Autor:innen

Katharina Eisenbarth studiert an der Universität Tübingen Geschichtswissenschaft im Master of Arts. Gemeinsam mit Dr. Alexa von Winning hat sie ein KI-Mentorat für Studienanfänger:innen entwickelt. Sie interessiert sich für osteuropäische Geschichte und journalistische Fragen.

Dr. Alexa von Winning lehrt und forscht am Institut für osteuropäische Geschichte und Landeskunde der Universität Tübingen. Ihre Schwerpunkte sind imperiale Geschichte, historische Biografik und Transformationsgeschichte in Osteuropa.

Mauritz Danielsson

Mauritz Danielsson

Peter van der Hijden

Peter van der Hijden

Annalisa Biehl

Annalisa Biehl