Recap: KI-Leitlinien als Beispiel für soziotechnische Aushandlungsprozesse

Recap: KI-Leitlinien als Beispiel für soziotechnische Aushandlungsprozesse

17.02.25

Leitlinien zum Umgang mit KI an Hochschulen – Orientierung oder Beruhigungsmittel? Ein Jahr nach dem ersten Überblick zieht das Hochschulforum Digitalisierung erneut Bilanz: Wie haben sich KI-Leitlinien weiterentwickelt? Welche neuen Kategorien sind hinzugekommen? Und warum sind sie nur dann wirksam, wenn sie kontinuierlich reflektiert und weiterentwickelt werden? Im Blogbeitrag schildert Blickpunkt-Autor Jens Tobor persönliche Eindrücke und Gedanken.

Ein Jahr ist vergangen, seit der HFD-Blickpunkt “Leitlinien zum Umgang mit generativer KI” erschienen ist. Damals untersuchte ich 27 hochschulweite Dokumente und Landingpages, die die Orientierung im Umgang mit generativer KI (genKI) in Lehre und Studium zum Gegenstand hatten. Da die meisten dieser untersuchten Dokumente und Landingpages darauf hinwiesen, dass die dort bereitgestellten Informationen nur eine begrenzte Aktualität haben, wurde auch der Blickpunkt selbst mit diesem Hinweis versehen. Zu dynamisch ist die Entwicklung der Technologie, wesentlich träger die Interpretation der daraus abzuleitenden Konsequenzen. Beide Facetten sind bei der Aktualisierung von Leitlinien zu beachten. Das ist kein einfaches Fahrwasser für die Entwickler:innen solcher Orientierungsdokumente, die ja nicht nur unterstützen sollen, sondern auch eine gewisse Verbindlichkeit haben – man denke an das vieldiskutierte Thema Prüfungen. Es ist daher an der Zeit, dass auch ich erneut Bilanz ziehe, was sich seit dem letzten Blickpunkt in puncto Leitlinienentwicklung getan hat. Denn nicht zuletzt beschäftigt mich seitdem die grundlegende Frage nach Sinn, Gelingensbedingungen, Möglichkeiten und Grenzen solcher Leitlinien. Einige persönliche Beobachtungen und Einschätzungen, die sich in den letzten Monaten aus dieser Auseinandersetzung ergaben, möchte ich an dieser Stelle teilen.

Takeaways: Blickpunkt Leitlinien

Rekapitulieren wir zunächst drei zentrale Takeaways aus dem Blickpunkt, die in meinen Augen nach wie vor gültig sind:

- Hochschulweite Leitlinien zum Umgang mit generativer KI erfüllen nach wie vor den Zweck, Orientierung zu stiften, indem sie begründete Ansätze zur Positionierung, Kontextualisierung und Regulierung bereitstellen.

- Die Leitlinien sprechen sich in der Regel für einen offenen und chancenbetonten, doch zugleich kritisch-reflektierenden Einsatz von genKI aus. Hier wird zumeist klar markiert, dass ein Verbot der Technologie nichts nützt, da die KI-Tools die Hochschulen ohnehin von innen heraus durch die KI-nutzenden Hochschulangehörigen erobern. Leitlinien, die dies nicht zum Ausgangspunkt ihrer Gestaltung machen, führen zum Gegenteil dessen, was mit ihnen bezweckt werden soll.

- In welcher Form die Regulierungsvorschläge der Leitlinien umgesetzt werden (z.B. im Rahmen einer Lehrveranstaltung), wird in den meisten Fällen den einzelnen Lehrenden im Kontext ihrer Fachdisziplinen überlassen.

Betrachten wir die Kategorien, die im Rahmen der letztjährigen Überprüfung der Leitlinien entwickelt wurden, so sind diese nach wie vor von Bedeutung. Dennoch hat sich auf dieser Ebene auch etwas getan.

Orientierung dank Differenzierung

Mit Blick auf das, was sich verändert hat, gerät eine stärkere Differenzierung zwischen der inhaltlichen Ausführung einer Kategorie und der Wahl des konkreten Orientierungsformates in den Blick. Was ist damit gemeint? Bei unserer Analyse vor einem Jahr fiel noch auf, dass die Bezeichnungen der Formate und deren Kategorieninhalte relativ lose in Bezug zueinander standen, also in Leitlinien didaktische Konzepte ausführlich ausgerollt wurden und in einer Empfehlung zur Integration von KI lediglich regulative, nicht aber inspirierende Aspekte benannt wurden. Dieses Wimmelbild erscheint nun ein Stück weit differenzierter:

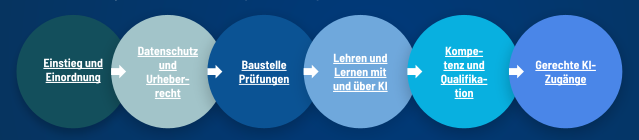

- Leitlinien geben eine knappe Einordnung zur Technologie, ein grundlegendes Statement zur KI-Positionierung der Hochschule und fokussieren dann auf regulatorische Aspekte. Aus diesem Blickwinkel werden dabei weitere Kategorien (siehe Abb. Bezugskategorien) angeschnitten.

- Didaktische Empfehlungen/Handreichungen setzen sich explizit mit der Integration von KI in die Lehre, dem Prüfen sowie dem Lernen auseinander. Sie bieten Inspiration und Konzepte, um das Lehren und Lernen im Kontext der Technologie zu reflektieren. Dabei spielen auch die Sensibilisierung für Kompetenzen wie AI-Literacy und genuin menschliche Fähigkeiten eine wichtige Rolle.

- Eigenständigkeitserklärungen & KI-Dokumentationsformen dienen als hilfreiches Muster zur fakultäts- oder veranstaltungsspezifischen Modifikation in Zeiten von genKI im Prüfwesen.

- Übersichten zu Unterstützungsangeboten bieten praktische Hilfestellungen in Form von Ansprechpersonen, weiterführenden Aufklärungsmaterialien, internen und externen Kompetenz- und Qualifikationsangeboten.

- Hinweise zu KI-Zugängen, soweit bereits geschaffen, weisen auf datenschutzkonforme und auf die Zwecke der Hochschulen ausgerichtete KI-Zugänge hin und sensibilisieren beispielsweise für Nutzungsvorteile und Limitationen der angebotenen KI-Modelle.

Ebenso nehme ich eine noch stärkere Differenzierung der Formate hinsichtlich Zielgruppen (insbesondere Studierenden & Lehrende) wahr. An vielen Stellen bieten KI-Landingpages der Hochschulen einen kompakten Blick auf all die entstandenen Formate, um die durch die Differenzierung geschaffene Bandbreite wieder kompakt einzufangen. Ein tolles Beispiel ist meines Erachtens der KI-Hub der Universität Vechta.

KI-Zugang, -Verordnung & -Kompetenzen

Wenn wir noch einen Moment bei den Kategorien bleiben, so stelle ich auch fest, dass einige dieser Kategorien im Vergleich zur Analyse vor einem Jahr an Profil gewonnen haben. Erfreulich ist beispielsweise, dass eine Vielzahl an Hochschulen einen Zugang zu KI-Modellen geschaffen haben. Wie oben bereits erwähnt, werden Hinweise zur datenschutzgerechten Nutzung, Technik und zu den Vorteilen dieses Zugangs in Orientierungsformaten gegeben (z.B. bei BIKI der Universität Bielefeld). Das impliziert theoretisch auch neue Möglichkeiten, KI in neue Prüfungsformate unter der Bedingung eines chancengleichen Zugangs zu integrieren. Darauf wird meiner Kenntnis nach aber bislang eher zögerlich hingewiesen. Ein Grund dafür könnte sein, dass der KI-Zugang der Hochschulen häufig erst erprobt und schrittweise eingeführt wird, um zu sehen, was die Nutzung in Bezug auf Kosten, Überlastung und Limitierungen mit sich bringt. Erst wenn diese Erfahrungen gemacht und die damit verbundenen Hürden überwunden sind, kann ein chancengleicher Zugang für die Erbringung von Prüfungsleistungen verantwortet werden.

Die Thematik des Zugangs zu KI wird im Kontext der Chancengleichheit durch die am 2. Februar dieses Jahres in Kraft getretene europäische KI-Verordnung (KI-VO) weiter hervorgehoben und konkretisiert. Stellen Hochschulen KI-Systeme bereit – was sie müssen, wenn sie deren Einsatz gestatten – dann ist dies mit einer Reihe von Anforderungen verbunden. Die KI-VO nimmt Hochschulleitungen in die Pflicht. So ist z.B. sicherzustellen, “dass all diejenigen, die in ihrem Auftrag KI einsetzen, ‘KI kompetent’ sind”, was impliziert, “dass Beschäftigte und Studierende ‘rechtlich und technisch einschätzen können, was es bedeutet, KI einzusetzen’”, so Datenschutzrechtler Prof. Dr. Rolf Schwartmann in einem Artikel in Forschung und Lehre. Die KI-VO definiert KI-Kompetenzen dabei als „die Fähigkeiten, die Kenntnisse und das Verständnis, die es Anbietern, Betreibern und Betroffenen unter Berücksichtigung ihrer jeweiligen Rechte und Pflichten im Rahmen dieser Verordnung ermöglichen, KI-Systeme sachkundig einzusetzen sowie sich der Chancen und Risiken von KI und möglicher Schäden, die sie verursachen kann, bewusst zu werden“ (Art. 3 Nr. 56 KI-VO). Dies mobilisiert eine Reihe von Kompetenzerwartungen, die nicht nur regulatorischer und technischer, sondern auch ethischer Natur sind.

Dass dieser Konnex in den KI-Leitlinien bislang nicht klar als verpflichtende Aufgabe der Hochschulleitung aufgeführt wird (bzw. vor dem Inkrafttreten antizipativ aufgegriffen wurde), mag der offenen Frage geschuldet sein, welche Bedingungen an den Hochschulen de facto erfüllt sein müssen, damit von einem KI-kompetenten Umgang im Sinne der KI-VO gesprochen werden kann. Auch wenn die erwarteten Kompetenzen in der KI-VO herleitbar sind, bleiben diese nach meinem Eindruck zum einen eher abstrakt. Sie müssen im Sinne der Anwendung an Hochschulen nun weiter ausbuchstabiert werden. Zum anderen zeigt ein Blick auf die Zahlen aber auch, dass die Angebote zur KI-Kompetenzentwicklung an Hochschulen grundsätzlich noch ausbaubedürftig sind (Budde & Friedrich 2024, S. 65) – dass also möglicherweise an vielen Hochschulen noch nicht selbstbewusst behauptet werden kann: “Wir bieten ausreichend Angebote zur Entwicklung von KI-Kompetenzen”. Das darf jedoch nicht über die Tatsache hinwegtäuschen, dass es gerade im Rahmen offen zugänglicher Qualifizierung für alle Hochschulangehörigen mittlerweile schon ein breites Angebot gibt, wie unsere kommentierte Linksammlung eindrucksvoll zeigt. Hochschulen scheinen diese Angebote bisweilen noch zu wenig systematisch für sich nutzbar zu machen.

Neben dem Kompetenzerfordernis gibt es ein weiteres wichtiges Element der KI-VO, das prädestiniert ist, in KI-Leitlinien eine Rolle zu spielen: die Risikostufen für KI-Systeme. Wie die Handreichung der TH Köln bereits ausdrücklich aufweist, bestehen eine Einstufung zum Hochrisiko-Systeme, wenn KI die Transparenz, Genauigkeit, Sicherheit und den Schutz der Grundrechte beeinträchtigt. Dies ist beispielsweise bei der Bewertung von Prüfungsleistungen durch KI-Systeme der Fall.

“Die Bewertung von Prüfungsleistungen fällt in diese Klasse nach Anhang III Nr. 3 und wird damit als ein hohes Risiko für Nutzende angesehen. Das bedeutet, dass Prüfende KI-Systeme, also insbesondere auch ChatGPT oder das GPT-Lab, egal ob sie von der Hochschule bereitgestellt werden, über andere Anbieter zur Verfügung gestellt oder privat erworben werden, nicht für die Bewertung von Prüfungen zugelassen sind. Prüfende tragen die persönliche Verantwortung und haften dementsprechend, sofern sie KI zur Bewertung von Studienleistungen einsetzen” (Handreichung für Lehrende zum Umgang mit dem THKI GPT-Lab)

Welche neuen Kategorien sind mir begegnet?

Kommen wir nun zu weiteren potenziellen Kategorien für KI-Orientierungsformate, die mir im Zuge meiner Nachbetrachtung aufgefallen sind.

- Barrierefreiheit dank KI-basierten Anwendungen: Wie im Fall der Handlungsempfehlungen des ZLI der FU Hagen, widmet sich ein Kapitel den unterschiedlichen Unterstützungsmöglichkeiten, die KI-Tools bieten, um das Studium für Menschen mit Behinderung barrierefreier zu machen.

- Sensibilisierung für den Ressourcenverbrauch: Der Einsatz generativer KI-Tools ist ressourcenintensiv. Auch das ist Teil der Orientierung zur bewussten Nutzung von KI-Chatbots & Co., wie es z.B. bei KI in der Lehre der Uni Konstanz ausgewiesen wird. Noch eindrücklicher wird es, wenn, wie im Falle der transparent gemachten Nutzerstatistiken des KI-Chabots der Universität Hamburg, der CO2-Verbrauch aller Anfragen aufgeführt wird.

- Diversitätssensibler Umgang mit KI: Generative KI-Modelle enthalten Biases – durch die Nutzung der Tools reproduzieren sich z.B. Stereotype und Diskriminierungsmuster. Diese Punkte berühren viele Leitlinien, aber es gibt bisher nur wenige weitere Orientierungsformate, die dem Thema mehr Raum und Tipps geben, wie mit Biases umzugehen ist. Sie können somit zum Lerngegenstand selbst zu werden, wie das Beispiel der FU Berlin zeigt.

Fest steht, dass sich die KI-Leitlinien und weitere Orientierungsformate weiterentwickelt haben. Es besteht jedoch eine Hürde, die mich seit meiner Beschäftigung mit dem Thema nicht mehr losgelassen hat.

Leitlinie als Beruhigungsmittel – Was, wenn die Wirkung nachlässt?

Orientierung tritt an die Stelle von Unwissen und Unsicherheit im Umgang mit KI, wenn sich Hochschulangehörige mit KI-Leitlinien auseinandersetzen, so die Vorstellung. Wie bereits als Takeaway im Blickpunkt “Leitlinien zum Umgang mit generativer KI” formuliert, ist dafür die erste essenzielle Bedingung, dass die Hochschulangehörigen überhaupt von der Existenz der Leitlinien und weiteren Orientierungsformaten erfahren. Daraus folgt nach jeder Leitlinienentwicklung oder -aktualisierung ein Kommunikationsauftrag, der die ‘harte Kost’ der Regulierung an die Leute bringen muss. Neue Wege in puncto Informierung schlägt hier das DDLitLab der Universität Hamburg ein. Auf ihrer KI-Landingpage findet sich das Angebot zweier KI-Newsletter, die man abonnieren kann, um up to date zu bleiben. Einer der beiden Newsletter richtet sich an relevante Informationen für Studierende, der andere dezidiert an Lehrende.

Eine zweite essenzielle Bedingung, damit Leitlinien überhaupt wirksam werden, liegt darin, sie zum reflexiven Gegenstand der fortlaufenden Aushandlung von KI in Studium und Lehre zu machen. Einwegkommunikation, wie im obigen Abschnitt Thema, ist ein guter Start, reicht aber nicht aus. Warum nicht?

Die den meisten KI-Leitlinien innewohnende offene und chancenbetonte Rahmung, die es den Rezipient:innen erlaubt, sie durch die Brille ihrer eigenen Praxis- und Fachkontexte auf das Konkrete zu übertragen, ist wichtig, zugleich aber auch ihre größte Schwäche. Was meint das? Unsicherheiten im Umgang mit KI können durch die Lektüre einer Leitlinie zwar zunächst absorbiert werden, verlagern sich dann aber nicht selten in die Situation der fachspezifischen Auslegungen im unmittelbaren Handlungskontext.

Besonders deutlich wird dies z.B. im Umgang mit Prüfungen. Zwar kann ich als Prüfer:in die in der Leitlinie vorgeschlagene generelle Zulassung von KI-Systemen in Prüfungen unter Wahrung der akademischen Integrität als Option ziehen, aber ein didaktisch sinnvolles und rechtlich wasserdichtes Prüfungsformat ergibt sich daraus noch nicht. Sowohl bei der Prüfung als auch bei der Integration von KI in die Lehre im Allgemeinen tauchen die zuvor absorbierten Unsicherheiten im Konkreten wieder auf. Der Möglichkeitsraum, der sich entlang der Leitlinien aufspannt, kann an dieser Stelle zum Beispiel durch didaktische Empfehlungen (siehe Differenzierung) zwar weiter geschlossen werden, doch bleiben Ungewissheiten bestehen, die nur ko-kreativ geschlossen werden können – im Gespräch mit Kolleg:innen, Supporteinrichtungen, anderen Hochschulen und, ganz zentral, den eigenen Studierenden. Sich hier gemeinsam als Lernende zu begreifen, mag gerade wegen der noch immer spürbaren Hierarchisierung zwischen Lehrenden und Lernenden schwerfallen und deshalb nicht selten ignoriert werden. Die Folgen wären sich manifestierende Vorbehalte und Misstrauen zwischen den Parteien im Umgang mit KI, wovor u.a. auch im empfehlenswerten Whitepaper “Generative AI in higher education: Current practices and ways forward” (Liu & Bates 2025) ausdrücklich gewarnt wird. Dabei handelt es sich bei diesem gemeinsamen Lern- und Aushandlungsprozess eigentlich um ein mächtiges Motivationsmomentum.

Es ist also zentral, Orientierungsformate als Rahmenwerk zum weiteren Aushandlungsprozess nutzbar zu machen. Schließen möchte ich an dieser Stelle mit ein paar Beispielen, die diesem Mantra folgen:

- “Per Prompt-Battle zur Eigenständigkeitserklärung” ist ein Workshopkonzept von Dr. Sanne Ziethen aus dem Team des Projekts Digital C@MPUS-le@rning, das das Ziel hat, den Dialog zwischen Studierenden und Lehrenden über den verantwortungsvollen Einsatz von KI-Tools zu fördern. Dies geschieht, indem die Studierenden ein Prompt-Battle durchlaufen: In mehreren Runden entwickeln und testen sie Prompts, die auf wissenschaftliche Aspekte wie Recherche, Eigenständigkeit, kritisches Denken und Wissenschaftlichkeit abzielen. In der gemeinsamen praxisorientierten Auseinandersetzung über Möglichkeiten und Grenzen des KI-Einsatzes in verschiedenen Phasen des Lern- und Arbeitsprozesses kommen Studierende und Lehrende dann in einen Dialog über die Optionen der Eigenständigkeitserklärung (mit den Varianten „verbotener Einsatz“, „erlaubter Einsatz mit Dokumentation der Tool-Verwendung pro Arbeitsschritt“ und „gebotener Einsatz von KI“). Die Art des KI-Einsatzes wird so nicht von der Lehrperson allein, sondern nachvollziehbar mit und für die Seminargruppe getroffen. Das Konzept wird weiter erprobt und so ausgestaltet werden, dass es flexibel an unterschiedliche Fachkulturen angepasst werden kann.

- Studierenden-Vertreter:innen in KI-AGs und Taskforces: Die KI-Leitlinienentwicklung stellt nicht selten das Arbeitsergebnis von KI-AGs und ähnlichen Organisationsformen an Hochschulen dar. Studentische Vertreter:innen für diese AGs zu mobilisieren ist ein Weg, die Perspektivenvielfalt auf Orientierungsfragen zu erweitern und Arbeitsergebnisse aus dieser Perspektive reflektieren zu können. Ein Orientierungsformat, in dem dies ausgewiesener Weise stattgefunden hat, ist z.B. die Handreichung der HafenCity Universität.

- Entwicklung auf Verbundebene: Ähnlich wie bei der Bereitstellung von KI-Systemen ist auch im Bereich der KI-Leitlinien und ähnlicher Orientierungsformate zu beobachten, dass diese auf der Ebene von Hochschulverbünden, in Netzwerken (z.B. Handreichung „Ethische Nutzung von KI“) oder sogar auf der Ebene ganzer Bundesländer entwickelt werden. Ein Beispiel dafür ist die niedersächsische Austauschrunde zu KI, die aus einer Initiative der LandesHochschulKonferenz (LHK) der „AG Digitale Lehre“ hervorging. Im Rahmen der Austauschrunde kristallisierten sich verschiedene, thematisch ausgerichtete Arbeitsgruppen heraus – darunter auch eine, die sich mit rechtlichen Fragen (z. B. Prüfungen, Policies, Handreichungen) beschäftigt. Diese Gruppe veröffentlichte zuletzt orientierungsstiftende Hinweise und Arbeitsmaterialien zum identifizierten Schwerpunkt „KI-Gebrauch im Studienkontext dokumentieren“ und versteht die geschaffene Ressource als einen weiterentwickelbaren Vorschlag, der von Hochschulen – nicht nur in Niedersachsen – aufgegriffen werden kann, aber nicht muss. Auf die Frage, welche Vorteile sich aus der kollaborativen Entwicklung solcher Formate ergeben, hebt die Arbeitsgruppe insbesondere die Perspektivenvielfalt hervor, die durch die unterschiedlichen wissenschaftlichen Sozialisationen und Tätigkeitsfelder der Beteiligten entsteht. Dies ermöglicht es, sowohl fachspezifische als auch akteursspezifische Bedarfe zu berücksichtigen. Zudem erweitern sich die zur Verfügung stehenden Kapazitäten durch das hochschulübergreifende Zusammenwirken. Als zentrales Motiv nennt die Gruppe die Zuversicht, durch gemeinsames Arbeiten die komplexen Herausforderungen besser bewältigen zu können, als es im Alleingang möglich wäre. PD Dr. habil. Dagmar Knorr, AG-Mitglied und Mitautorin der angesprochenen Ressource, ist überzeugt, dass Hochschulen, Lehrende und Studierende froh sein werden, auf übergreifende Empfehlungen (oder sogar Leitlinien) zurückgreifen zu können. Dass sich viele Diskussionen insbesondere am Thema des wissenschaftlichen Schreibens entzünden, mobilisiert die Expertise der Leiterin des Schreibzentrums der Leuphana Universität Lüneburg. Akteur:innen solcher Einrichtungen und vergleichbarer Art sind essenzielle Mitglieder solcher Kooperationsbeziehungen – eine Erkenntnis, die wir seitens des HFD immer wieder bestätigen können.

- Studentische Sichtweise und Expertise: Über hochschulinterne Angebote hinaus ist es ebenso ratsam, studentische Forderungen zum Umgang mit KI an Hochschulen auf bundesweiter Ebene zu berücksichtigen. Der KI-Sprint der Digital Change Maker bündelt studentische Positionen zu den Themen „Haltung und Partizipation“, „Regelungen für Lernen und Prüfen“, „Digitale Teilhabe“ und „Qualifizierung“ und bringt sie gezielt in aktuelle Diskurse ein.

Fazit

Die Entwicklung von Leitlinien und weiteren Orientierungsformaten stellen nicht den Endpunkt, sondern einen Ausgangspunkt eines Aushandlungsprozesses zum KI-Umgang dar. Die Notwendigkeit besteht darin, KI-Leitlinien & Co. als lebendige Orientierung zu verstehen, die im perspektivreichen Dialog weiterentwickelt werden müssen. Gerade darin liegt die Stärke dieser Formate: Sie schaffen einen Reflexionsrahmen, aus dem die gewonnenen Erfahrungen in die KI-induzierte Hochschultransformation zurückfließen – und zwar unter notwendiger Berücksichtigung von Chancen und Risiken.

Mauritz Danielsson

Mauritz Danielsson

Peter van der Hijden

Peter van der Hijden

Annalisa Biehl

Annalisa Biehl