KI-generierte Zusammenfassungen und Analysen in Veranstaltungen: praktische Erfahrungen und Empfehlungen zum Nachmachen

KI-generierte Zusammenfassungen und Analysen in Veranstaltungen: praktische Erfahrungen und Empfehlungen zum Nachmachen

24.10.24

Wie kann KI zur Analyse und Zusammenfassung von Inhalten bei Veranstaltungen eingesetzt werden? In drei Experimenten nutzte Andreas Sexauer KI-Tools, um Diskussionen und Vorträge effizient zu dokumentieren und zu visualisieren. Dabei wurden sowohl Vorteile, wie schnelle Verarbeitung und anschauliche Darstellung, als auch Herausforderungen bei der Genauigkeit und Tiefe der Ergebnisse deutlich.

Nicht reden, sondern machen

Im Januar 2024 stellte mir ein Kollege eine einfache Frage:

„Das Wissenschaftsministerium Baden-Württemberg plant eine Veranstaltung für Hochschulen zum Thema KI in der Lehre. KI soll dabei nicht nur diskutiert, sondern auch aktiv verwendet werden. Hast du eine Idee, wie das aussehen könnte – und traust du dir zu, das umzusetzen?“

In diesem Blogbeitrag stelle ich die Ergebnisse, die konkrete Anleitung zum Nachmachen und die Weiterentwicklung der Idee in drei Experimenten vor.

Die Idee selbst und deren Umsetzung ist überraschend einfach und erfordert keine spezielle Soft- oder Hardware. Es genügen allgemein verfügbare KI-Software und die Möglichkeit, den Vortrag oder eine Diskussion als Audiodatei aufzuzeichnen. Diese Datei wird mit einer KI-Software in ein Transkript umgewandelt. Anschließend kann der Text mit einer generativen KI zusammengefasst und anhand gezielter Fragen analysiert werden. Mit einem kleinen Trick lässt sich die Text-KI sogar dazu bringen, die Ergebnisse visuell darzustellen. Innerhalb weniger Minuten steht der Output zur Verfügung und kann entweder für den Einstieg in eine Podiumsdiskussion oder zur allgemeinen Dokumentation genutzt werden.

Das erste Experiment: „KI in der Hochschullehre“

Am 11. März 2024 fand in Stuttgart eine Vernetzungsveranstaltung des Wissenschaftsministeriums Baden-Württemberg zum Thema „KI in der Hochschullehre“ statt. Während des Brainstormings im Vorfeld wurden schnell ein paar wichtige Grundsätze klar:

- Mehrwert durch KI: Der KI-Einsatz sollte so in den Ablauf der Veranstaltung integriert werden, dass mit den Inhalten echte Mehrwerte entstehen, die ohne KI nicht praktikabel realisierbar wären.

- Einfachheit und Nachvollziehbarkeit: Das Vorgehen sollte so gestaltet sein, dass Teilnehmende es leicht nachvollziehen und einordnen können.

- Erlebbarkeit: Es sollte ein Experiment sein, das die Möglichkeiten von KI innerhalb der Veranstaltung erlebbar macht.

- Menschliche Kontrolle: Am Ende sollte die KI nicht unangefochten „Recht haben“, sondern der Mensch die Möglichkeit haben, die Ergebnisse zu bewerten, einzuordnen und – falls notwendig – zu korrigieren.

- Datenschutz: Die Audioaufzeichnung geht nur mit freiwilliger Einwilligung. Die Verarbeitung sollte möglichst lokal ablaufen.

Aus dieser Grundlage entwickelte sich die Idee, in den Veranstaltungssessions am Vormittag die einleitenden 17 Transferimpulse aufzuzeichnen und in mehreren Schritten zusammenzufassen. Dieses experimentelle Verfahren durfte ich vom Karlsruher Institut für Technologie (KIT) zusammen mit dem Hochschulnetzwerk Digitalisierung der Lehre Baden-Württemberg (HND-BW) durchführen.

Die Vorträge wurden mit Zustimmung der Referent:innen aufgezeichnet – Diskussionen und Fragerunden blieben dabei unberücksichtigt. Die Transferimpulse waren in sechs parallele Themenblöcke organisiert. Die 17 Audiodateien wurden einzeln transkribiert und mit den entsprechenden Vortragstiteln und Namen der vortragenden Personen angereichert. Jeder dieser Texte wurde mit dem speziell entwickelten? Prompt „Zusammenfassung Einzelvortrag“ auf etwa 1000 Wörter reduziert, wobei Kernaussagen, offene Fragestellungen, Thesen und Handlungsempfehlungen extrahiert wurden.

Alle verwendeten Prompts und die Ergebnisse sind auf

https://www.hnd-bw.de/veranstaltungen/ki-lehre/

dokumentiert.

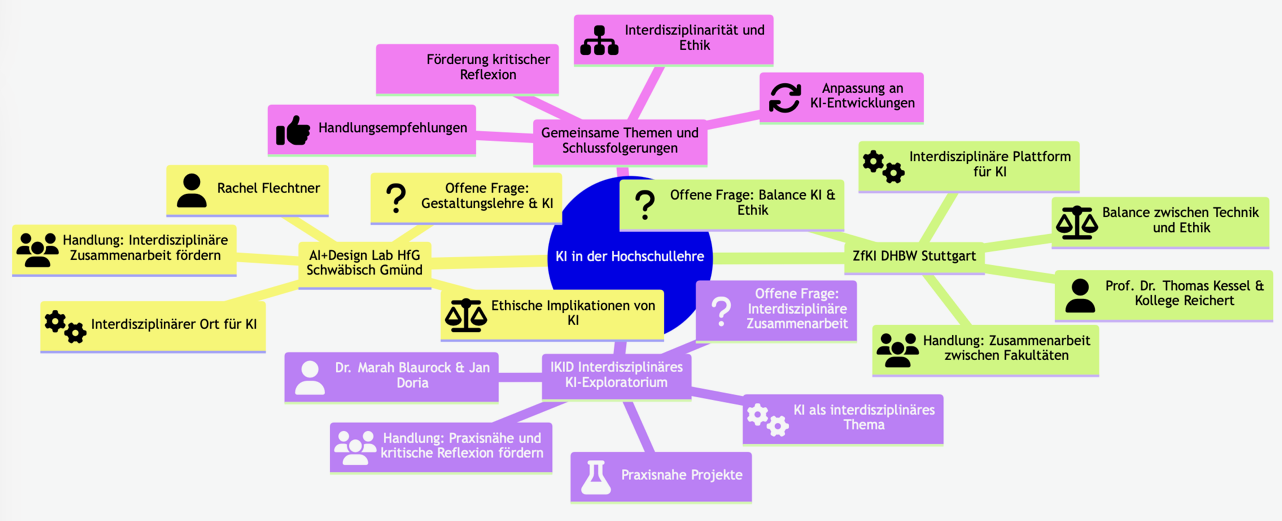

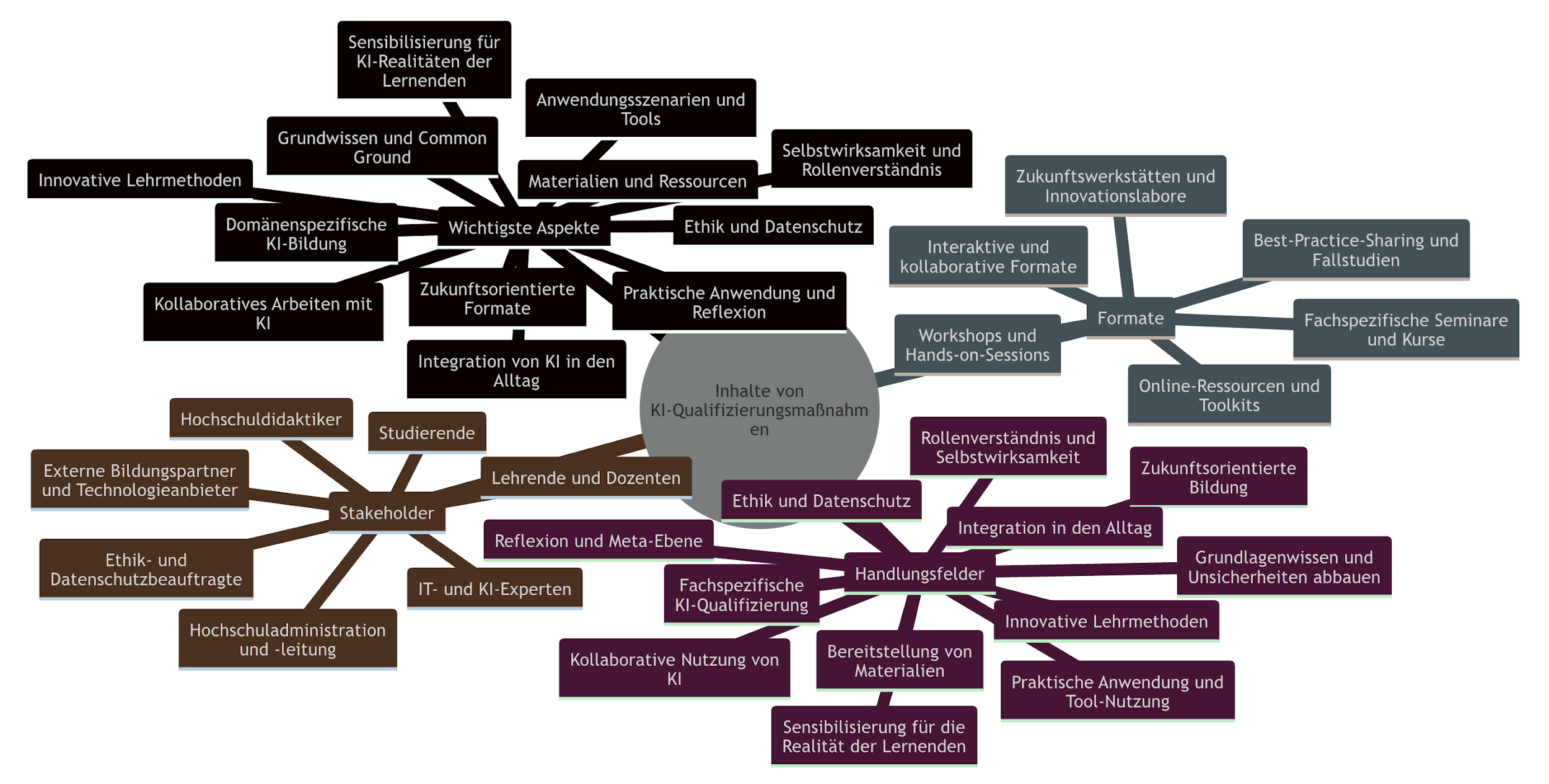

Für die Synthese der Vorträge innerhalb einer Themensession nutzte ich einen weiteren Prompt („Synthese der Vorträge in einer Themensession“), der die einzelnen Zusammenfassungen in eine einheitliche Struktur brachte und gemeinsame Themen und Diskussionen identifizierte. Um die Ergebnisse visuell zugänglicher zu machen, wollte ich diese mit einer MindMap darstellen. Mermaid als Beschreibungssprache für MindMaps kannte ich bereits. Da die Syntax auf einfachem strukturierten Text basiert, sollte es gelingen, ChatGPT zu einer solchen Ausgabe zu überreden. Leider kannte gpt-3.5 diese Syntax nicht. Es musste daher ein entsprechender Prompt „MindMap“ vorbereitet werden. Da die Syntax auch die Integration von Icons aus dem „Font Awesome“ Zeichensatz erlaubt, wurde zusätzlich die Aufforderung einer Anreicherung mit passenden Icons ergänzt. Ein so erstelltes Ergebnis zeigt Abbildung 1.

Die Zusammenfassungen und MindMaps der sechs Themenschwerpunkte wurden direkt im Anschluss der Vorträge während der Mittagspause in knapp 45 Minuten erstellt und auf die Veranstaltungswebseite gestellt. Bei 17 Vorträgen und den technischen Gegebenheiten ein etwas hektisches Unterfangen. Inzwischen ließe sich das deutlich bequemer umsetzen, mehr dazu im Abschnitt „Was hat sich in nur sechs Monaten technisch verändert?“.

Die Teilnehmenden der Tagung konnten die Ergebnisse nach der Mittagspause ansehen und über eine Online-Befragung Rückmeldung geben. Der Rücklauf war mit 24 Teilnehmenden zwar quantitativ relativ gering, qualitativ jedoch sehr gehaltvoll. Aus dem Textfeedback und persönlichen Gesprächen habe ich für mich sowohl positive wie kritische Aspekte mitgenommen.

Positive Aspekte:

- Die gelungene, umfassende Darstellung der Hauptthemen wurde besonders gelobt.

- Die akkurate und sprachlich gut formulierte Wiedergabe der Vorträge wurde positiv hervorgehoben.

- Die Erstellung der MindMaps wurde als wertvolle Strukturierungshilfe anerkannt.

- Die korrekte Zusammenfassung des einzigen englischsprachigen Vortrags auf Deutsch wurde positiv wahrgenommen.

Kritische Anmerkungen:

- Einige Rückmeldungen wiesen auf „Halluzinationen“ hin, wie die Interpretation nicht vorhandener Gemeinsamkeiten zwischen Vorträgen und die Erwähnung von Themen, die nicht diskutiert wurden.

- Es kam zu Fehlern bei der Nennung von Namen und der Angabe von Referent*innen trotz ihrer Abwesenheit.

- Die Zusammenfassungen wurden als zu allgemein und oberflächlich empfunden, mit einer Tendenz, Nuancen und Details zu übersehen, was zu generischen Aussagen führte, die nicht die volle Komplexität oder spezifische Thesen der Vorträge widerspiegelten.

Daraus ergaben sich für mich mehrere Lessons Learned:

- Das Prompt-Design ist entscheidend: Die Qualität der Ergebnisse hängt stark von der Formulierung der Prompts ab. Die KI neigt dazu, Antworten auf gestellte Fragen zu geben, auch wenn diese Informationen nicht im Transkript enthalten sind. Die Prompts oder Einstellungen des Modells müssen diesbezüglich verändert werden, damit dies in geringerem Ausmaß erfolgt.

- Unzuverlässigkeit bei wörtlichen Zitaten: Bei der Generierung wörtlicher Zitate aus den analysierten Vorträgen hat sich die verwendete KI als in hohem Maße unzuverlässig erwiesen. Solange hierfür kein zuverlässiges Tool zur Verfügung steht oder die Problematik mittels Prompt-Design gelöst werden kann, sollte die Aufforderung zur Ausgabe wörtlicher Zitate mit besonderer Vorsicht verwendet werden.

- Menschliche Überprüfung ist unerlässlich: Die KI- Ergebnisse sollten stets durch menschliche Überprüfung ergänzt werden – entweder in Form einer Bewertung oder der Verwendung als Ausgangsbasis für weitere Bearbeitungen.

- Metadaten sind wichtig: Eine fehlerhafte Eingabe der Metadaten kann zu falschen Ergebnissen führen. Bei einem Vortrag gab es eine kurzfristige Änderung der vortragenden Person. Da der Prompt mit den Metadaten aus dem Programm gefüttert wurde, war die genannte Person in der Zusammenfassung entsprechend falsch.

- Robustes Verfahren: Das Verfahren ist erstaunlich robust, trotz der Verwendung des „German Large“ Modells in Whisper und Weiterverarbeitung mit auf deutsch formulierten Prompts, ist das in der deutschsprachigen Zusammenfassung nicht in einer generell anderen Qualität erkennbar.

- Kostenaspekt: Der Einsatz ist keine Kostenfrage. Für die Durchführung des dargestellten Verfahrens beliefen sich die Kosten für OpenAI-API-Aufrufe auf etwa 2,50 $.

Das zweite Experiment: Podiumsveranstaltung „KI – Perspektiven für die Hochschullehre“

Am 20. März 2024 fand in Karlsruhe die Podiumsveranstaltung „KI – Perspektiven für die Hochschullehre“ statt, organisiert vom Karlsruher Institut für Technologie (KIT) in Zusammenarbeit mit dem Hochschulnetzwerk Digitalisierung der Lehre Baden-Württemberg (HND-BW) und der Virtuellen Hochschule Bayern (vhb). Diese Veranstaltung fand nur wenige Tage nach dem ersten Experiment statt.

Das Ziel bestand darin, die sechs Impulsvorträge und eine sich daran anschließende Podiumsdiskussion unter Expert*innen auf verschiedenen Themenfeldern der Künstlichen Intelligenz mithilfe von KI aufzubereiten und zu analysieren. Die Herausforderung lag darin, die Inhalte so aufzubereiten, dass sie nach einer 20-minütigen Kaffeepause als Grundlage für eine zweite Diskussionsrunde dienen konnten.

Insgesamt gab es also drei große Herausforderungen:

- Zeitdruck: Der gesamte Ablauf musste dieses Mal in nur 20 Minuten bewältigt werden.

- Die Prompts sollten besser auf den Kontext zugeschnitten sein.

- Das Ergebnis musste so komprimiert sein, dass es auf eine Präsentationsfolie passt und sowohl für das Publikum als auch für die Podiumsdiskussionsteilnehmenden schnell genug erfassbar ist..

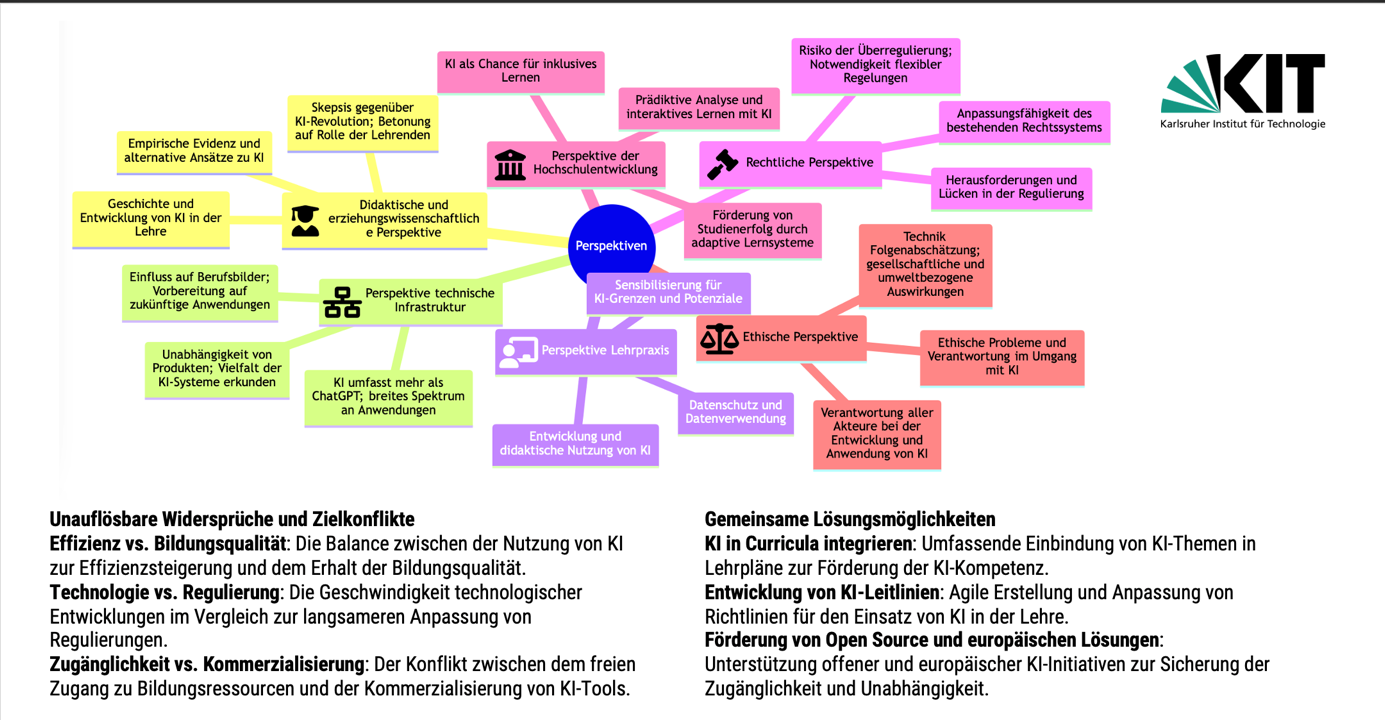

Das Ergebnis ist in Abbildung 3 dargestellt. Wer will, kann sich auf der Webseite auch die einzelnen – sehr zu empfehlenden – Vorträge als Aufzeichnung ansehen und so selbst das Ergebnis der KI-Zusammenfassung beurteilen.

Neben der Zusammenfassung der einzelnen Impulse über die MindMap sollte die KI eine Art Zusammenschau vornehmen. Diese sollte unauflösbare Widersprüche und Zielkonflikte sowie mögliche gemeinsame Lösungsmöglichkeiten identifizieren.

Die vollständige Dokumentation mit den Prompts kann auf

https://www.hnd-bw.de/veranstaltungen/podium-ki

nachgeschaut werden.

Trotz des knappen Zeitrahmens gelang es, die Ergebnisse rechtzeitig fertigzustellen, sogar in Form eines gedruckten Handouts für die Expert*innen auf dem Podium. Ich durfte dann gleich mit auf das Podium und mit der Moderatorin Britta Leusing vom KI-Campus kurz das Vorgehen diskutieren. So hatten die Personen auf dem Podium kurz Zeit, ihre Positionen in der KI-Zusammenfassung zu überprüfen.

Parallel wurde eine Publikumsbefragung zur Qualität der KI-generierten Zusammenfassung durchgeführt. Von den 76 Teilnehmenden wurde eine durchschnittliche Bewertung von 3.25 auf einer Skala von 1 (sehr schlecht) bis 5 (sehr schlecht) erreicht. In den Freitextfeldern wurde besonders häufig die gute Übersicht (15% der Befragten) hervorgehoben. Ebenfalls positiv bewertet wurden die klare Strukturierung sowie die gelungene Visualisierung des Diskussionsverlaufes. Kritisch wurden vor allem die geringe Tiefe und das Fehlen von wörtlichen Zitaten eingestuft.

Im Anschluss gab die MindMap einen guten Aufhänger, nochmals mit frischem Blick in die zweite Runde der Podiumsdiskussion zu starten. Generell fanden sich die Vortragenden gut zusammengefasst, auch wenn die gewählten Begriffe nicht immer perfekt getroffen waren. Trotzdem war klar, auf welche Inhalte sich die KI bezog.

Mein persönliches Fazit:

- Die Umsetzung hat trotz des hohen Zeitdrucks gut funktioniert und konnte flüssig in die gesamte Veranstaltung eingebettet werden.

- Die gezielte Anpassung des Prompts auf den Kontext der Veranstaltung hat die Qualität des Ergebnisses gegenüber dem ersten Experiments deutlich gesteigert.

- Kleinere Probleme in der Ausgabe, wie die Formatierung der MindMap, konnten über Rückfragen im Chat-Dialog leicht während der Durchführung behoben werden.

- Die Metaanalyse der Widersprüche, Zielkonflikte und Ansätze für gemeinsame Lösungsansätze übertraf die Erwartungen und lieferte wertvolle Diskussionsansätze.

- Der in der KI-generierten Zusammenfassung aufgeworfene Widerspruch zwischen Effizienz und Bildungsqualität wurde vom Podium kritisch diskutiert. Hier waren die von ChatGPT gegenübergestellten Positionen wohl begrifflich nicht gut gewählt gewesen.

Das dritte Experiment: Workshop „KI-Kompetenzen für die Lehre stärken – Erfahrungen und Zukunftsperspektiven“

Nach den positiven Erfahrungen aus den ersten beiden Experimenten stellte sich die Frage, ob sich der KI-Einsatz auch im Rahmen eines 1,5-stündigen Workshops umsetzen lässt. Der geplante Beitrag des Netzwerks Landeseinrichtungen digitale Hochschullehre (NeL) und der Stiftung Innovation in der Hochschullehre (StIL) auf der Konferenz “Learning:AID” war in drei Phasen strukturiert: Nach einer kurzen Einleitung sollte ein Welt-Café-Format mit drei Thementischen und eine daran anschließende Fishbowl-Diskussion folgen. Als Veranstalter des Workshops hatten sich NeL und StIL von Anfang an gewünscht, nicht nur über KI zu reden, sondern diese auch aktiv in den Ablauf zu integrieren.

In der Umsetzung ergaben sich drei wesentliche Herausforderungen:

- Die Auswertung musste noch schneller durchgeführt werden als in den vorherigen Experimenten.

- Die KI sollte eine andere Rolle als die der reinen Ergebnisdokumentation einnehmen.

- Die Audioaufzeichnung von drei parallelen Diskussionen im selben Raum stellte eine technische Herausforderung dar.

Die akustische Frage konnte durch einen einfachen Test gelöst werden: Ein Mittagessen in der lauten KIT-Mensa mit einem Mikrofon mitten auf dem Tisch zeigte, dass die parallelen Gespräche gut ausgeblendet werden konnten. Im Transkript war fast ausschließlich die Unterhaltung der vier Personen rund um das Mikrofon enthalten. Beim Workshop auf der Learning:AID selbst saßen rund 50 Teilnehmende um drei Tische. Die Mikrofone führten überraschend zu einer ruhigen und geordneten Atmosphäre. Alle wurden selbstverständlich zu Beginn über die Aufzeichnung und das Vorgehen informiert und um ihr Einverständnis gebeten.

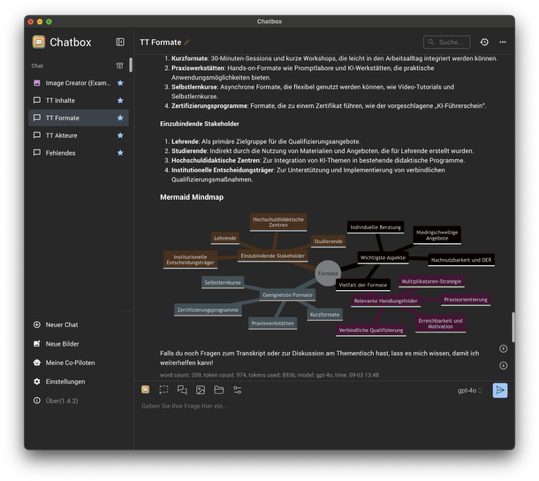

Schwieriger war die strukturelle Integration des KI-Einsatzes in diesem Setting: Wie konnte die KI-Auswertung ohne Pause im Workshop entstehen? Die Lösung war die Rolle des KI-Sidekicks. Direkt nach der Welt-Café-Phase gingen die Audioaufzeichnungen der Diskussionen den Thementischen an mich als KI-Sidekick. Ich saß an einem Tisch direkt neben der Fishbowl-Diskussion und begann mit der Auswertung, während der Moderator die Diskussion leitete. Um die Transkription zu beschleunigen, kam das Small Modell von Whisper (siehe: „Der Ablauf und die Technik zum Nachmachen“) zum Einsatz. Dieses transkribiert zwar weniger präzise, aber dafür etwa dreimal schneller als das bisher verwendete Large Modell. Die Prompts waren bereits in der App Chatbox AI vorbereitet, sodass das Transkript nur noch jeweils per Copy und Paste eingefügt werden musste.

Vier Prompts wurden genutzt: Jeweils ein an den Thementisch angepasster Prompt zur Zusammenfassung als MindMap und Ermöglichung weiterer spontaner Rückfragen sowie ein weiterer, übergreifender Prompt „Fehlendes“.

Dank des schnellen gpt-4o-Modells und der Weiterentwicklung der Werkzeuge, wie im Abschnitt „Was hat sich in nur sechs Monaten technisch verändert“ beschrieben, lagen die Ergebnisse nach nur acht Minuten vor. Die erste MindMap wurde auf die Projektionsfläche geworfen, und sowohl Moderator als auch die Teilnehmenden konnten die Ergebnisse direkt in die Diskussion einbeziehen.

Die Moderator*innen der Thementische bestätigten größtenteils die von der KI zusammengefassten Inhalte. Auch die Teilnehmenden konnten sich darin wiederfinden. Auf den ersten Blick gab es nichts offensichtlich Falsches. Allerdings gab es Anmerkungen, dass Inhalte zu verkürzt auf Schlagworte reduziert wurden und so wichtige Nuancen verloren gingen.

Viel spannender waren die Ergebnisse des Prompts „Fehlendes“. Der Gedanke hinter diesem Prompt entstand bereits in der Planungsphase des Workshops: Da die Teilnehmenden aufgrund der drei parallelen Thementische nicht in der Lage waren, alle Diskussionen vollständig zu verfolgen, sollte die KI diese Lücke füllen. Dementsprechend zielte der Prompt darauf ab, die Zusammenfassungen der Thementische daraufhin zu analysieren, welche Themen in der Gesamtheit nicht diskutiert wurden, aber dennoch berücksichtigt werden sollten.

Das Ergebnis zeigt Abbildung 5. Zuerst fällt in der Mitte der MindMap die etwas ungeschickte Formulierung auf. Es ging in der Diskussion eher um die Metaebene, statt um Inhalte für die Weiterbildungsangebote selbst. Die Äste sind stimmig, die Mitte nicht. Die Reaktion auf die MindMap war eine Mischung aus „Bull-Shit-Bingo“ und wertvollen Hinweisen. Besonders der naheliegende, aber bisher noch nicht betrachtete Aspekt, nicht nur national, sondern auch international zu kooperieren, wurde als wertvoller Impuls aufgenommen.

Mein persönliches Fazit:

Ich war positiv überrascht, wie gut sich die akustischen und zeitlichen Herausforderungen meistern ließen. Die Rolle des KI-Sidekicks, inspiriert von Late-Night-Show-Formaten, ist für mich ein guter Ansatz zur Integration der KI in eine Diskussion. Dieser Ansatz beinhaltet zwei Ebenen der menschlichen Reflexion und Bewertung. Einerseits kann ich als KI-Anwender bei groben Fehlfunktionen eingreifen, einordnen oder korrigieren, wobei ich möglichst neutral bleibe. Andererseits können die Teilnehmenden der Diskussionsrunde auf der inhaltlichen Ebene reagieren.

Besonders spannend ist, dass der KI-Sidekick dynamische Interaktionen mit der Diskussion ermöglicht. So können gezielt Rückfragen oder neue, in der Diskussion entstehenden Fragen direkt an die KI gestellt werden. Als Sidekick kann ich dann diese Fragen live an die KI weitergeben und die Prompts entsprechend anpassen. Ein Beispiel dafür war die Frage am Ende, welche Handlungsempfehlungen die KI geben würde. Die kurze Frage erzeugte eine Liste, die ich mit einer schnellen Nachfrage in eine übersichtliche MindMap umwandeln konnte.

Zwei Dinge würde ich nächstes Mal anders machen: Erstens würde ich keine reinen Zusammenfassungen mehr zeigen. Diese führen häufig zu Diskussionen über einzelne schlecht gewählte Begriffe oder Details, was in diesem Kontext nicht zielführend ist. Stattdessen wären analytische Prompts, wie der „Fehlendes“-Prompt, deutlich wertvoller für die Diskussion. Diese Art von Fragen bringt die Diskussion auf eine tiefere Ebene und lenkt den Fokus auf relevante inhaltliche Aspekte. Solche Ideen sollten jedoch gut im Voraus vorbereitet werden.

Zweitens würde ich noch dynamischer agieren und die KI so vorbereiten, dass spontan, je nach Diskussionsverlauf, analytische Fragen gestellt werden können. Beispielsweise könnte die KI gefragt werden, welche Herausforderungen an mehreren Thementischen genannt wurden. Ich bin überzeugt, dass dieser dynamische Ansatz die Qualität der Veranstaltung steigern und den Nutzen der KI erheblich erweitern würde.

Insgesamt sehe ich im KI-Sidekick ein großes Potential als ein bereicherndes Werkzeug im Veranstaltungsdesign. Nicht nur als Beispiel für den KI-Einsatz bei Veranstaltungen zum Thema KI, sondern auch in anderen Kontexten.

Prompt Entwicklung

Meine Prompts für diese Art des Einsatzes entwickle ich nach einem Muster – und mit einem kleinen Trick. Der Trick besteht darin, einen ersten Entwurf des Prompts mit der KI selbst zu erstellen. Dazu formuliere ich eine grobe Beschreibung dessen, was ich von der Assistenz als Unterstützung erwarte, und bitte die KI, eine klare, schrittweise Arbeitsanweisung zu entwerfen. Diese Anweisung überarbeite ich dann nach dem Schema eines Megaprompts:

- Rolle und Persona der KI festlegen

- weitere Struktur der Aufgabenbeschreibung darlegen

- Kontext bereitstellen, in der Regel beschreibe ich den Veranstaltungsrahmen und die spezifische Funktion, die die KI bei der Auswertung erfüllen soll

- Ziel der Aufgabe beschreiben, inklusive was ich an Umfang und Struktur erwarte.

- einzuhaltender Ablauf in Schritten als nummerierte Aufzählung

Bevor die Prompts zum Einsatz kommen, teste ich sie und verbessere sie bei Bedarf. Beispielsweise war beim ersten Einsatz ursprünglich vorgesehen, die KI-generierten Ergebnisse jeweils mit wörtlichen Zitaten aus dem Transkript zu untermauern. Die Tests haben schnell ergeben, dass die Antworten zwar formal als Zitate formatierte Passagen enthielten, diese aber zu erheblichen Anteilen „halluziniert“ und keinesfalls wortwörtlich den tatsächlichen Aussagen entsprachen. Aufgrund dieser Einschränkung entschied ich, bei der Veranstaltung auf wörtliche Zitate zu verzichten. Zum Testen der Prompts nutze ich entweder vorhandene Aufzeichnungen eigener Vorträge oder von der KI generierte, fiktive Transkripte. Diese reichen in der Regel aus, um die Plausibilisierung der Prompts zu prüfen und bei Bedarf anzupassen.

Der Ablauf und die Technik zum Nachmachen

Während der KI-Einsatz zur Anreicherung von Veranstaltungen konzeptionell gut vorbereitet sein will, ist die technische Durchführung überraschend einfach. Alles was benötigt wird, ist ein Internetzugang, die Open Source Software Whisper, ein Mikrofon mit Aufzeichnungsmöglichkeit und ein Laptop mit Zugang zu einem generativen Sprachmodell wie gpt-4o. Im Folgenden beschreibe ich die einzelnen Schritte, die im Experiment 3 zum Einsatz kamen.

Schritt 0 – Prompt Entwicklung (vorbereitend)

Am Anfang steht ein didaktisches Design. Die KI-gestützten Analysen sollen integraler Bestandteil des Veranstaltungsdesigns sein. Die KI kann beispielsweise genutzt werden, um sachliche Zusammenfassungen als Grundlage für weitere Phasen zu erstellen. Oder, wie im dritten Experiment, um Diskussionen an Thementischen auf fehlende Aspekte zu untersuchen, die eine Podiumsdiskussion im Anschluss erweitern können. Dafür entwickle ich sogenannte Mega-Prompts, die aus Kontext (Veranstaltungsbeschreibung), Rolle der KI, Vorgehensweise, erwartetes Ergebnis in Inhalt, Struktur und Format bestehen. Dies ist im Abschnitt „Prompt Entwicklung“ genauer beschrieben.

Schritt 1 – Audioaufzeichnung (lokal)

In der Praxis hat sich bei mir das Funkmikrofonset Max von Hollyland Lark (siehe Abbildung 7) bewährt. Die beiden enthalten Mikrofone können mit dem Clip auf der Rückseite an der Oberbekleidung einer Person angesteckt werden oder in der Mitte eines Tisches positioniert werden. Beide Mikrofone können per Tastendruck Audiodateien lokal auf dem Gerät aufzeichnen. Es gibt auch Modelle von anderen Anbietern (z.B. Rode, DJI), die für diesen Zweck geeignet sind. Nach der Aufnahme werden die Mikrofone wie ein USB-Stick mit dem Computer verbunden und die Datei der Aufnahme steht zur Verfügung.

Schritt 2 – Transkription (lokal)

Im nächsten Schritt wird die Audiodatei in ein Transkript umgewandelt. Aus Gründen des Datenschutzes erledige ich dies immer rein lokal und nicht mit einem Cloud-Dienst. Nach der Transkription lösche ich die Audiodateien. Ich verwende dazu Whisper auf einem M3-Apple Laptop. Für diesen gibt es im App-Store eine Whisper App, die einfach zu bedienen ist. Ähnliche Programme gibt es auch als kostenlose Variante für Mac und Windows, z.B. kann Vibe verwendet werden. Wer sich etwas mehr auskennt, kann Whisper auch von GitHub installieren und in der Kommandozeile verwenden. Voraussetzung ist jeweils eine von Whisper unterstützte Grafikkarte (GPU) mit ausreichender Leistung. Je nach zur Verfügung stehender Zeit wähle ich zwischen dem Small- oder Large-Modell von Whisper: Das Large-Modell ist in der Genauigkeit der Texterkennung exakter, braucht dafür aber deutlich länger. Mit dem Large Modell rechnet meine Hardware für einen 30 Minuten Vortrag etwa 3 Minuten, mit dem Small Modell rund 1 Minute. Ist die eigene Hardware nicht gut genug, gibt es zahlreiche Cloud-Dienste, die zum gleichen Ergebnis führen, aber in Bezug auf den Datenschutz bedenklicher sind.

Schritt 3 – Zusammenfassung und Analyse (Cloud)

Für die Zusammenfassung und Analyse bereite ich die Prompts im Voraus vor. In diesen gebe ich dem Sprachmodell den Kontext der Veranstaltung und Anweisungen zur Auswertung sowie zum gewünschten Ergebnis. Die Prompts enden jeweils mit der Aufforderung, mich als erstes nach dem Transkript zu fragen. Aus Gründen der Usability verwende ich nicht die ChatGPT-Webseite, sondern die App Chatbox AI. Dort kann ich bequem das zu verwendende Modell und Parameter für das Modell wie die Temperatur einstellen. Ebenfalls kann diese Software in der Mermaid-Syntax erstellte Visualisierungen wie eine MindMap der Zusammenfassung direkt anzeigen (Abbildung 8). Dies spart mir den Umweg über einen Mermaid-Editor, um die grafische Ausgabe zu erstellen.

Schritt 4 – Präsentation und Einbettung der Ergebnisse

Die Präsentation der Ergebnisse erfolgt abhängig von der Art der Veranstaltung. In den Experimenten wählte ich drei unterschiedliche Ansätze. Besonders angenehm fand ich die direkte Präsentation der App Chatbox AI auf die Projektionsleinwand, da dadurch eine direkte Interaktion mit den Ergebnissen in Experiment 3 möglich wurde. Hier hatte ich die Schriftgröße maximal eingestellt und mit der in MacOS eingebauten Bildschirmvergrößerung gearbeitet, um beispielsweise nur auf die MindMap zu zoomen. Auch das Befüllen einer vorher vorbereiteten Folie per Screenshot der MindMap sowie Copy&Paste von Textabschnitten im Experiment 2 war leicht umzusetzen.

Wichtiger als die technische Umsetzung ist eine Ergebnispräsentation, die der im Vorfeld definierten Funktion der KI im Rahmen der Veranstaltung gerecht wird. Eine klare Kommunikation darüber, dass die Resultate von der KI generiert wurden, sowie eine Erläuterung des zugrunde liegenden Prozesses gehören für mich ebenfalls dazu.

Was hat sich in nur sechs Monaten von März bis September 2024 technisch verändert

Innerhalb von nur sechs Monaten – von März bis September 2024 – hat sich die technische Umsetzung meiner KI-Experimente deutlich vereinfacht und verbessert. Einige der früheren Herausforderungen sind durch die rasche Weiterentwicklung der Technologie beseitigt worden. Hier einige der wichtigsten Veränderungen:

- Erhöhte Eingabekapazität: Während der Verwendung war die Eingabe auf maximal 4.000 Zeichen pro Anfrage beschränkt, nun erlaubt gpt-4o inzwischen bis zu 25.000 Wörter pro Eingabe. Zum Vergleich: Eine 30 Minuten Diskussion hat etwa 4.500 Wörter. So kann ich das gesamte Transkripts in einem Schritt per Copy&Paste einfügen, anstatt es mühsam in kleinere Teile zu zerlegen, wie es vorher erforderlich war. Früher musste ich dazu Tools wie den ChatGPT PROMPTs Splitter verwenden

- Direkte Erstellung von MindMaps: Mit gpt-3.5 musste noch ein kleiner Trick verwendet werden, um auch eine Ausgabe als MindMap in der Mermaid-Syntax zu erhalten. Zuerst erstellte ich über einen Prompt eine gegliederte Zusammenfassung. Mit einem zweiten Prompt erklärte ich dem Modell die Syntax einer solchen MindMap und ließ die Zusammenfassung entsprechend transformieren (siehe Prompt MindMap). Dann musste dieses Ergebnis über einen Mermaid-Editor in ein Bild umgewandelt werden. Inzwischen reicht mit gpt-4o die Anweisung „Gebe dies als Mermaid MindMap aus!“ im Prompt. Chatbox AI zeigt die so erzeugte Antwort direkt als Bild an (vgl. Abbildung 8).

- Schnellere Antwortzeiten: Mit gpt-3.5 war anfangs die Ausgabe noch recht langsam. Bis die gesamte Antwort angezeigt wurde, dauerte es schon mal eine halbe Minute. Mit gpt-4o ist die Antwort in wenigen Sekunden vollständig. So kann auch live eine Rückfrage an die KI gestellt werden, ohne eine peinliche Pause zu erzeugen.

Bereits diese wenigen Beispiele zeigen die immer noch anhaltende Dynamik der Weiterentwicklung. Ich bin überzeugt, dass wir noch am Anfang stehen. In Zukunft könnte beispielsweise eine vollständige Automatisierung des gesamten Prozesses möglich sein oder Werkzeuge zur Verfügung stehen, die live eine MindMap der laufenden Diskussion erstellt und anpasst. Beides dürfte in der Umsetzung mit Verwendung der OpenAI-API ein eher kleines Entwicklungsprojekt sein. Auch der Wunsch nach wörtlichen Zitaten, der aktuell noch schwierig ist, dürfte bald umsetzbar sein, indem man gezielt mit den Parametern wie „Temperatur“ und „Top-P“ des Modells spielt.

Fazit und Ausblick

Die Integration von KI zur Generierung von Zusammenfassungen und Analysen in Veranstaltungen hat in den durchgeführten Experimenten hilfreiche Ergebnisse erzielt. Mit einfachen Mikrofonen und allgemein verfügbarer KI-Software lassen sich Veranstaltungen effizient dokumentieren und wertvolle Erkenntnisse gewinnen. Die positiven Rückmeldungen, insbesondere zur Strukturierung und Visualisierung der Inhalte, bestätigen den Mehrwert dieses Ansatzes. Gleichzeitig haben die Experimente Schwachstellen gezeigt, insbesondere die Herausforderung, eine Balance zwischen inhaltlicher Tiefe und Genauigkeit sowie einem angemessenen Umfang zu finden.

Die kontinuierliche Weiterentwicklung der eingesetzten Technologien, wie die verbesserte Verarbeitungskapazität von gpt-4o und optimierte Transkriptionsmodelle, hat die Durchführung erheblich erleichtert und die Qualität der Ergebnisse gesteigert. Diese Fortschritte zeigen das große Potenzial und die Dynamik, die im Bereich der KI-gestützten Veranstaltungsanalyse liegen.

In Zukunft könnte die Rolle der KI in Veranstaltungen weiter ausgebaut werden. Denkbar sind automatisierte Systeme, die Live-Analysen und Visualisierungen generieren, um Diskussionen noch interaktiver und datengetriebener zu gestalten. Die Entwicklung spezialisierter Tools, die nahtlos in den Veranstaltungsablauf integriert werden können, eröffnet hierbei spannende Möglichkeiten. Zudem könnte die KI als „Sidekick“ in Diskussionen eine dynamischere und flexiblere Interaktion ermöglichen, indem sie spontan auf neue Fragen und Themen reagiert.

Insgesamt sollte KI nicht nur als technisches Hilfsmittel oder spielerisches Element betrachtet werden, sondern als integraler Bestandteil des Veranstaltungsdesigns. Die kontinuierliche Anpassung und Verbesserung der eingesetzten Methoden und Werkzeuge werden dazu beitragen, neue, innovative Formate zu schaffen.

Autor

Andreas Sexauer ist Mitarbeiter am Zentrum für Mediales Lernen und setzt sich dort mit digitalen Bildungstechnologien auseinander, damit diese in der Lehre des KIT zum Einsatz kommen. Seine aktuellen Schwerpunkte sind dabei KI, hybride Lehrformate und Medienproduktion.

Mauritz Danielsson

Mauritz Danielsson

Peter van der Hijden

Peter van der Hijden

Annalisa Biehl

Annalisa Biehl