Digitale und geistige Souveränität in Zeiten von KI: Eine Standortbestimmung für den Hochschulbereich

Digitale und geistige Souveränität in Zeiten von KI: Eine Standortbestimmung für den Hochschulbereich

06.02.25

In welchem Maß können Hochschulen im KI-Zeitalter noch als digital souverän gelten? Wie abhängig sind sie von kommerziellen KI-Anbieter:innen, was können sie selbst gestalten? Und: Müssen Hochschulen auch Sprachmodelle in die eigene Hand nehmen, um unabhängiges wissenschaftliches Denken zu sichern? Dr. Peter Salden vom Zentrum für Wissenschaftsdidaktik der Ruhr-Universität Bochum gibt einen Überblick und bewertet die aktuelle Situation. Der Text entstand auf Grundlage seines Beitrags zur Expertenanhörung Digitale Souveränität, die das Hochschulforum Digitalisierung im Dezember 2024 in Köln ausrichtete.

Digitale Souveränität in Zeiten von KI

Das Thema digitale Souveränität beschäftigt Hochschulen schon deutlich länger als das Thema Künstliche Intelligenz (KI). Inwieweit können Hochschulen unabhängig von kommerziellen Anbieter:innen werden? Können sie Software selbst programmieren, selbst pflegen und Daten auf eigenen Servern speichern? Beim Lern- und Campusmanagement haben sie gezeigt, dass dies durchaus möglich ist. Andere Beispiele, wie zum Beispiel die Nutzung von Office-Produkten, zeigten dagegen auch Grenzen auf. Und dann kam KI.

Ein Sprung zurück ins Jahr 2023: Angehörige deutscher Hochschulen lernen die Welt der generativen KI kennen – in der Regel über ChatGPT. Sie registrieren sich auf der Homepage von OpenAI mit ihren persönlichen Daten, nutzen den von der Firma angebotenen Chatbot. Die dabei entstehenden Daten werden auf den Servern der Firma verarbeitet. Nicht immer sinnvolle Experimente finden statt, teils fehlt bei Nutzenden und in den Institutionen das Verständnis für die Technik. Es ist der Wilde Westen des KI-Zeitalters in Hochschulen.

Was würde digitale Souveränität demgegenüber bedeuten? Für die Einzelnutzer:innen wäre es ein Umgang mit KI, der um Funktionsweise, Chancen und Grenzen dieser Technik weiß; also eine Nutzung auf Grundlage sogenannter „AI Literacy“. Aus Perspektive einer Institution würde digitale Souveränität außerdem bedeuten, für einen KI-Dienst nicht auf kommerzielle Anbieter:innen angewiesen zu sein und stattdessen technische Elemente selbst in der Hand zu halten. Zudem würde digitale Souveränität auch bedeuten, institutionelle Rahmenbedingungen für die Nutzung festgelegt zu haben – rechtliche Regeln, aber zum Beispiel auch Strategien für den didaktischen Einsatz sowie für die Fortbildung des Personals.

Im Jahr 2024 sind die Hochschulen auf dem Weg zu KI-Souveränität große Schritte vorangekommen. Doch es gibt Herausforderungen – gerade auch im technischen Bereich.

Technische Komponenten

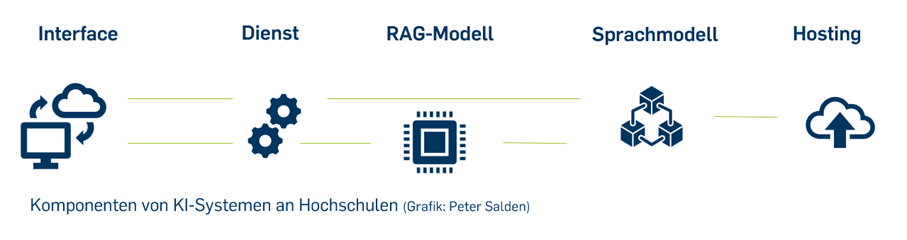

Technisch gesehen geht es bei KI-Bereitstellung um unterschiedliche Komponenten, die Hochschulen entweder über kommerzielle Anbieter:innen beziehen oder aber selbst entwickeln und betreiben können. Den Nutzer:innen am nächsten ist eine Web-Oberfläche (Interface), über die ein konkreter Dienst angeboten wird. Dies kann also beispielsweise eine Homepage sein, die einen allgemeinen Chatbot zugänglich macht. Aber auch andere Dienste sind denkbar, wie zum Beispiel Tools für das Feedback zu schriftlichen Arbeiten. Von großer Wichtigkeit ist im Bildungskontext, dass der Dienst – also zum Beispiel der Chatbot – möglichst faktentreu reagiert. Viele Hochschulen arbeiten daher an Lösungen für so genannte „Retrieval Augmented Generation“ (RAG)-Systeme. Gemeint ist ein technisches Verfahren, bei dem sich Antworten auf vorgegebene Fakten beziehen. Egal ob mit oder ohne RAG, ist der Kern des Systems dann das Sprachmodell, das eine Anfrage verarbeitet. Am Ende müssen alle Daten auf Servern abgelegt werden (Hosting). Wichtig im Zusammenspiel sind zudem die Schnittstellen zwischen den Komponenten.

Jede dieser Komponenten können Hochschulen theoretisch selbst in die Hand nehmen – und tun dies teils auch bereits. Im Sinne einer Standortbestimmung lässt sich mit Blick auf die einzelnen Komponenten Folgendes sagen:

Besonders verbreitet ist in den deutschen Hochschulen derzeit das Verfahren, über ein eigenes Web-Interface per Programmierschnittstelle (API) Sprachmodelle von OpenAI (und anderen Anbieter:innen) zugänglich zu machen – in der Regel für einen allgemeinen Chat-Dienst. Anders als bei der Nutzung der Modelle direkt über die kommerziellen Internetseiten verbleiben bei diesem Verfahren die persönlichen Anmeldedaten in der Hochschule. Beim Chatten werden nur die Chatanfragen (prompts) und allgemeine institutionelle Daten an die externen Dienstleister:innen weitergegeben – ein Fortschritt für den Datenschutz.

Als Herausforderung erweist es sich, dass durch den mittelbaren Zugang nicht automatisch alle Funktionen angeboten werden können, die Nutzer:innen beispielsweise von ChatGPT kennen. Denn all diese Funktionen müssen für das eigene Interface „nachgebaut“ werden, was einen erheblichen Aufwand sowie ständigen Weiterentwicklungsbedarf bedeutet.

Auch spezielle Dienste (wie z.B. Feedbacktools für Texte) werden inzwischen auf Grundlage der verfügbaren Modelle in den Hochschulen erarbeitet. Technisch ist dies oft mit vertretbarem Aufwand zu schaffen. Bedacht werden müssen dabei dann aber auch Fragen der Integration in die vorhandene Systemlandschaft, also zum Beispiel die Anbindung des Dienstes an das Identity-Management-System der Hochschule oder die Integration als Plugin in das Lern-Management-System. Das Ergebnis kann ein kleines „KI-Ökosystem“ an unterschiedlichen Diensten sein, die für Lehrende und Studierende einer Hochschule verfügbar sind.

Auch das Thema RAG beschäftigt derzeit viele Hochschulen. Im Fokus steht das grundlegende Szenario, Chatbots für ihre Antworten mit einem klar umgrenzten Fundus an Informationen in Verbindung zu bringen (z.B. einem Vorlesungsskript in pdf-Form). Studierende sollen dann bei Interaktion mit dem Bot Antworten auf Grundlage genau dieser geprüften Fakten erhalten. Auch hier zeichnet sich ab, dass Hochschulen entsprechende Lösungen durchaus bereitstellen können. Deutlich wird dabei aber auch, dass bei diesem Thema (zum Beispiel dem sog. „Chunking“) noch Forschungsbedarf besteht, damit die Systeme möglichst verlässlich funktionieren – und dass es trotz der Möglichkeit, Faktentreue zu erhöhen, eine vollständige Gewähr für korrekte Ausgaben von Sprachmodellen nicht geben wird.

Das Training eines eigenen großen Sprachmodells (LLM) gilt als Aufgabe, die aufgrund der notwendigen Ressourcen (Expertise, Trainingsdaten, Rechenleistung …) von einer einzelnen Hochschule nicht zu leisten ist. Möglich ist für Hochschulen aber die Verwendung von Open-Source-Modellen, die sowohl auf eigenen Servern abgelegt als auch in ihrer Funktionsweise beeinflusst werden können (Finetuning). Konkrete Dienste, die auf Open-Source-Modellen (insb. selbst angepassten) beruhen, sind derzeit noch selten. Spürbar ist aber, dass das Interesse in diese Richtung zunimmt und in Hochschulen durchaus Expertise vorhanden ist, dies zu leisten.

Sofern Hochschulen sich für die Nutzung von Open Source-Modellen für permanent erreichbare Dienste (wie zum Beispiel einen Chatbot in der Studienberatung) interessieren, stellt sich die Frage, wo das Hosting von Dienst und Modell stattfinden kann. Dies ist insbesondere dann ein Problem, wenn an einer großen Hochschule viele tausend Personen rund um die Uhr einen Dienst nutzen können sollen. Die dafür notwendige Rechenleistung ist teuer und sollte möglichst gut ausgelastet sein, was gegen ein lokales Hosting spricht.

Um das Problem zu lösen, nutzen viele Hochschulen inzwischen die Möglichkeit, Open-Source-Modelle über externes Hosting bei kommerziellen Dienstleistern (zum Beispiel Microsoft Azure-Cloud) oder bei öffentlichen Einrichtungen (zum Beispiel GWDG in Göttingen) zu beziehen. Gerade auch die Nutzung hochschulübergreifender High Performance Computing (HPC)-Cluster rückt hierbei in den Blickpunkt. Allerdings ist diese Infrastruktur oft weder für einen „Rund um die Uhr“-Betrieb noch für eine hohe Zahl kleinteiliger Anwender:innen-Anfragen aus den Hochschulen ausgelegt, so dass mit Blick auf die HPC-Nutzung ebenfalls Hürden zu überwinden sind.

Zusammenarbeit

Hochschulen haben theoretisch durchaus Know-How und Ressourcen, um das Maß ihrer digitalen Souveränität in Zeiten von KI zu erhöhen. Klar ist allerdings auch: Dies für alle Einzelkomponenten eines KI-Systems zu leisten, ist keine Kleinigkeit und für Einzelhochschulen – gerade kleinere – kaum zu schaffen. Sinnvoll ist der Alleingang ohnehin nicht, denn während in großen Tech-Konzernen viele Leute an einem Problem arbeiten, arbeiten an den vielen deutschen Hochschulen derzeit noch zu häufig einzelne Leute unverbunden am selben Problem. Hochschulen sind nicht unbedingt schwach – aber digitale Souveränität im KI-Zeitalter geht nur durch eine Bündelung der Kräfte.

Tatsächlich zeichnen sich Kooperationen schon jetzt an allen Stellen in der Komponenten-Kette ab. Beispiel Interfaces für Chatbots: Hier haben sich Kooperationsvorhaben wie das Landesprojekt KI:Connect.nrw gebildet, über das ein User Interface für einen Chatbot Open Source zur Installation (oder landeszentralen Nutzung) allen interessierten Hochschulen zur Verfügung gestellt wird. Zu erwarten ist, dass perspektivisch an deutschen Hochschulen eine begrenzte Zahl solcher gemeinsam entwickelten Interfaces in Betrieb sein wird.

Ähnlich könnte es bei anderen Diensten kommen, die für viele Hochschulen interessant sind. Notwendig sind dafür nicht immer neue Gemeinschaften: Wichtige Ankerpunkte für die Zusammenarbeit bei der KI-Bereitstellung sind auch schon bestehende Gemeinschaften im Open-Source-Bereich, wie die Communities der Lern-Management-Systeme. Beispielsweise für die Integration RAG-basierter Chatbots in Moodle findet hier bereits intensiver Austausch statt.

Ein weiteres Beispiel für Zusammenarbeit ist das Hosting: Wie bereits erwähnt, werden Lösungen auch hier schon jetzt hochschulübergreifend gedacht und auch realisiert. So können Hochschulen aus ganz Deutschland auf Open Source-Modelle zugreifen, die im bundesfinanzierten KI-Servicezentrum KISSKI betrieben werden, vermittelt über die ebenfalls öffentlich finanzierte GWDG. Das Projekt Open Source-KI.nrw in Nordrhein-Westfalen zeigt zudem exemplarisch das Bestreben, landeszentrale HPC-Infrastruktur für alle Hochschulen eines Bundeslands zu öffnen. Zu erwarten ist, dass dieser Trend sich fortsetzt, d.h. dass Hochschulen großer Bundesländer gemeinsam auf landeseigene Rechenkapazitäten zugreifen und gerade kleine Bundesländer für das Hosting Infrastruktur aus anderen Ländern mitnutzen.

Die oben skizzierte Aufgliederung der KI-Bereitstellungskette in Komponenten macht deutlich, dass Zusammenarbeit aber nicht immer und überall notwendig ist – da beispielsweise spezifische Dienste durchaus auch in einer einzelnen Hochschule entwickelt werden können. Wünschenswert ist gleichwohl ein in Teilen koordiniertes Vorgehen für Softwareentwicklung und Hardwarenutzung, damit Hochschulen „KI-souveräne“ Lösungen flexibel nutzen können.

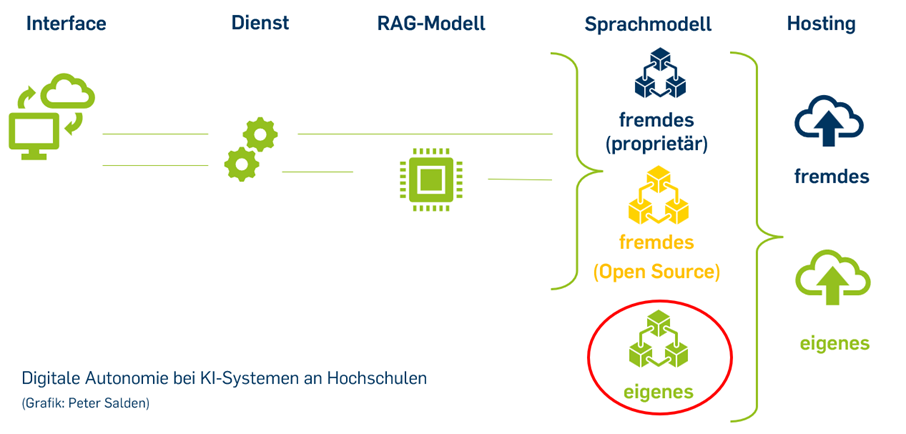

Ein unterschätztes Problem: geistige Souveränität

Schauen wir nach der Standortbestimmung auf das Gesamtbild: Kluge Zusammenarbeit vorausgesetzt, könnten Hochschulen perspektivisch Interfaces, Dienste und auch RAG-Modelle selbst bereitstellen sowie auch das Hosting-Problem lösen. Sie könnten in ihre Infrastruktur kommerzielle (proprietäre) oder Open-Source-Sprachmodelle einbinden. Um eine vollständig „auf grün stehende“, das heißt digital autonome KI-Infrastruktur anbieten zu können, gibt es aber eine Lücke in der Kette: die fehlenden eigenen Sprachmodelle.

Die Entwicklung eigener Sprachmodelle (insbesondere LLM) bleibt eine Herausforderung, die schier unüberwindbar erscheint, wenn man an die hohen Investitionskosten der kommerziellen Modelle denkt. Das Herzstück hochschulischer KI-Infrastruktur kommt dann aber immer von außerhalb, solange es keine Eigenentwicklungen gibt. Dies gilt letztendlich auch für Open-Source-Modelle, wenn sie (wie beispielsweise Llama) von einem großen Tech-Konzern trainiert wurden und dieser Prozess nicht in allen Details transparent ist.

Wieso ist das ein Problem? Schauen wir noch einmal in den Alltag an den Hochschulen: Immer häufiger geben Studierende (und Wissenschaftler:innen) Aufgaben erstmal in einen Chatbot ein und schauen, wie weit sie so für die Lösung ihrer Fragestellung kommen. Das Ergebnis wird dann nötigenfalls noch nachbearbeitet. Dies betrifft nicht nur die Darstellung von Fakten, sondern auch argumentative Aufgaben. Das Denken nimmt so immer stärker seinen Ausgang im Modell.

Aber: Die Sprachmodelle, auf denen Chatbots und sonstige Dienste basieren, haben nicht nur ein Problem mit der Korrektheit ihrer Antworten. Viel weniger beachtet ist, dass sie auch weltanschaulich nicht neutral sind. Ein chinesisches Sprachmodell ist aber in dieser Hinsicht ebenso feinjustiert wie ein amerikanisches Modell. Bisher war dies in Deutschland kaum ein Thema, da die westlichen Modelle in der Regel unseren Blick auf die Welt gut widerspiegelten und beispielsweise keine neonazistischen Parolen ausgaben. Aber wird das so bleiben?

Die Wahlen in den USA haben gezeigt, wie stark über Social Media das Denken beeinflusst werden kann und dass die Eigner der Social-Media-Kanäle ihre Macht über die Tools und ihre Algorithmen auszuspielen bereit sind. Was nun, wenn Sprachmodelle immer mehr Teil unseres Alltags werden und Studierende wie auch Wissenschaftler:innen ihre Argumentationen auf Antworten von Sprachmodellen aufbauen? Wie werden beispielsweise wissenschaftliche Texte zur Gender-Forschung aussehen, wenn Elon Musks als „anti-woke“ beworbener Chatbot „Grok“ für die Ausarbeitung genutzt wird? Wie werden Arbeiten zur chinesischen Geschichte aussehen, die ein chinesischer Chatbot generiert?

Diese Probleme zeigen, dass digitale Souveränität nicht nur eine Frage von Datenschutz und der Unabhängigkeit von kommerziellen Kostenmodellen ist, sondern dass die Kernfrage digitaler Souveränität in Zeiten von KI die geistige Souveränität ist. Sprachmodelle bringen ein erhebliches Risiko der unterschwelligen Manipulation mit sich. Sie betreffen die Freiheit des Denkens, mithin die Wissenschaftsfreiheit. Die Frage der Sprachmodelle ist damit die Schlüsselfrage der digitalen Souveränität. Und genau hier ist der Schwachpunkt (nicht nur) der Hochschulen in ihrem Bestreben, aus eigener Kraft diese Souveränität herzustellen.

Auf der Suche nach Lösungen

Alles in allem: Auf ihrem Weg zum Aufbau souveräner KI-Infrastrukturen sind die deutschen Hochschulen schon ein gutes Stück vorangekommen. Sie haben gezeigt, dass Vieles möglich ist – das stimmt optimistisch. Auch die an vielen Stellen entstehende Zusammenarbeit ist positiv. Offen bleibt aber die wichtige Frage, inwieweit auch die Sprachmodelle selbst von Hochschulen kontrolliert werden können.

Die Lage muss auch beim letztgenannten Punkt nicht hoffnungslos sein. Nein, Hochschulen werden nicht mit vergleichbaren Ressourcen wie die großen Tech-Konzerne eigene Sprachmodelle trainieren und weiterentwickeln können. Sie können aber noch stärker den Fokus auf die Weiterentwicklung von Open-Source-Modellen, auf die Übernahme in Europa entwickelter Modelle, auf die Kooperation mit kommerziellen europäischen Anbieter:innen oder auf die Entwicklung kleiner Sprachmodelle setzen. Hierauf sollte verstärkt der Fokus von Forschung, Entwicklung und Förderpolitik liegen. Hilfreich kann der Gedanke sein, dass für die Anwendungen der Hochschulen in Studium und Lehre, Forschung und Verwaltung gar nicht unbedingt immer der breite Funktionsumfang kommerzieller Large Language Models gegeben sein muss, sondern dass spezialisierte Anwendungen auch mit weniger Mitteln sehr gute Leistung für ihren Zweck erbringen können. Hoffnung macht zudem das Beispiel des chinesischen Modells DeepSeek insofern, dass hier offenbar das Training eines leistungsfähigen LLMs mit vergleichsweise geringem Aufwand gelungen ist.

Letztendlich zeigt aber gerade auch das Problem der Modelle, dass digitale Souveränität nicht allein auf der technischen Ebene gedacht werden sollte. Nutzer:innen von KI-Anwendungen in den Hochschulen müssen die Funktionsprinzipien und Risiken der Systeme verstehen, Hochschulen einen klaren Rahmen setzen. Technik, Literacy und institutionelle Rahmenbedingungen – dies sind die drei Handlungsfelder für digitale Souveränität in Zeiten von KI, an denen jetzt – oft hochschulübergreifend – gearbeitet werden muss.

Mauritz Danielsson

Mauritz Danielsson

Peter van der Hijden

Peter van der Hijden

Annalisa Biehl

Annalisa Biehl